La realidad aumentada de Google mejora mucho: ya detecta la profundidad

La realidad aumentada de Google mejora mucho: ya detecta la profundidad

Google ha puesto a disposición de los desarrolladores una API de AR Core que permite detectar la profundidad en realidad aumentada.

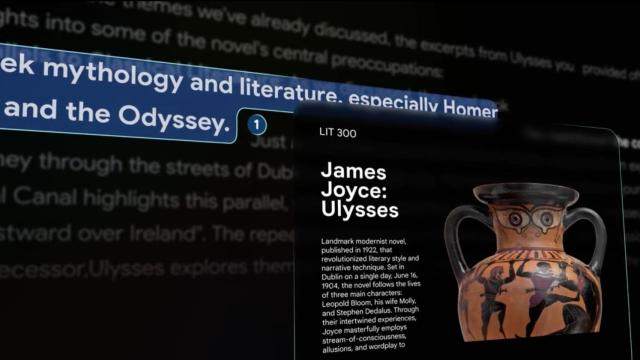

25 junio, 2020 15:12Son muchas las grandes empresas que están apostando muy fuertemente por la realidad aumentada y virtual. Apple, Facebook o Google son algunas de las más grandes.

Hace unos meses Google anunció que iba a poner en manos de los desarrolladores una nueva API que permitiría usar la realidad aumentada de los móviles Android, AR Corre, de forma mucho más avanzada, al poder captar la profundidad de las escenas que grabáramos.

Ahora la compañía ha confirmado que esta API ya es pública, e incluso que algunas aplicaciones, como Snapchat, la han integrado en sus últimas versiones.

Gran efectividad sin hardware especial

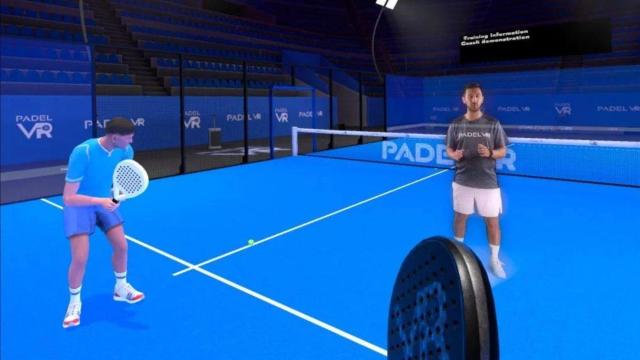

Una de las claves de esta tecnología es que Google ha conseguido ejecutarla en móviles que no tienen unas características especiales. Gracias a sus algoritmos pueden crear un mapa de profundidad, similar al que se usa en el modo retrato de los Pixel, que es lo que permitirá a los elementos virtuales interactuar con el entorno.

Estas novedades están ya disponibles para los desarrolladores en ARCore 1.18, tanto para Android como para proyectos que usan Unity.

Al implementarla en sus aplicaciones los desarrolladores podrán usar elementos virtuales en sus programas que se integrarán con el entorno en el que grabamos.

Además, la nueva API hará uso de los sensores ToF de algunos móviles para mejorar la calidad y precisión de las apps. Esto no quiere decir que esos sensores sean obligatorios para usar AR Core, pero sí que serán un elemento de apoyo.

Recordemos que si bien no todos los móviles del mercado son compatibles con AR Core, cada vez son más los modelos que sí lo son, incluyendo algunos de marcas como OPPO y realme que llevan poco tiempo en España.