Los robots humanoides han comenzado a coger tracción en España y en el resto del mundo. Sin ir más lejos, el Optimus Gen 2 de Tesla es un buen ejemplo de ello. Ahora, la compañía Figure da un paso más allá dando a conocer más detalles del Figure 01, el primer robot humanoide que cuenta con la tecnología de OpenAI en su interior, demostrando por el camino altas capacidades.

La idea, según explican desde Figure en un post de X (antes Twitter), es que con la tecnología de OpenAI su robot humanoide ahora puede tener conversaciones completas con humanos. Los modelos de la firma, detallan, "proporcionan inteligencia visual y lingüística de alto nivel". Tanto es así que el resultado grabado en un vídeo que adjuntan habría sido fruto de una red neuronal.

Y es que el Figure 01 de la compañía con mismo nombre aspira nada menos que a ser el primer robot humanoide de "propósito general comercialmente viable del mundo", dicen desde la firma. Los pasos a los que aprende el robot son agigantados, ya que por ejemplo en octubre del año pasado el robot ya se podía poner de pie y realizaba tareas básicas. A finales del 2023, ya podía observar y aprender de su entorno.

Así es el Figure 01 con modelos OpenAI

Esta prueba de concepto se llevó a cabo el pasado 9 de marzo de 2024, con la intención de probar las capacidades comunicativas del Figure 01 equipado con tecnología de OpenAI. En dicho metraje, un interlocutor humano conversa con el robot, preguntándole cuestiones acerca de su entorno, y los resultados son impresionantes.

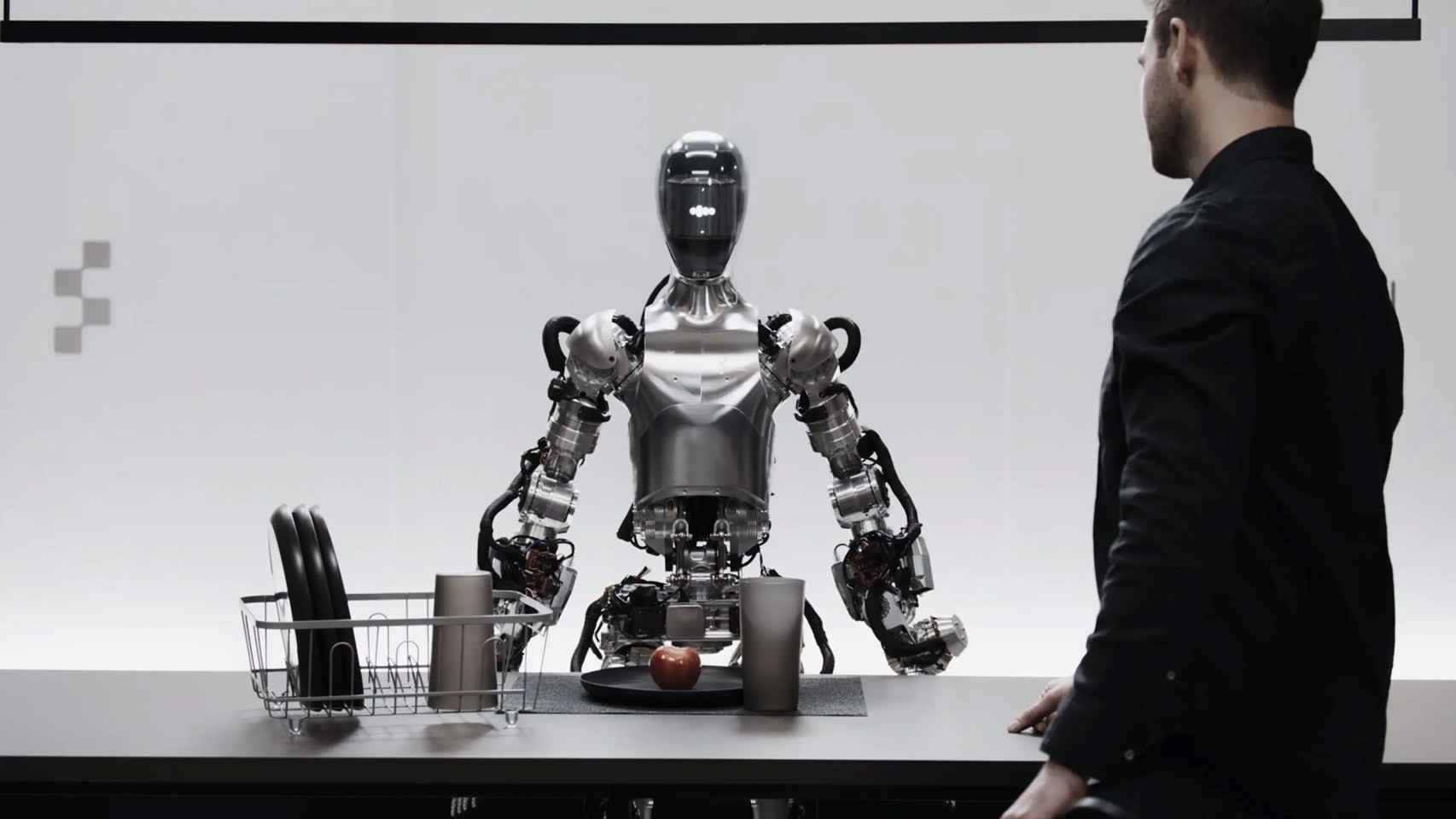

"Ey, Figure 01. ¿Qué estás viendo?", comienza preguntándole el operario de Figure. El robot contesta con certeza lo que ve: en este caso, con voz masculina, explica que ve una manzana roja, en una mesa negra y con cubertería y vasos. Incluso describe lo que hace el operario. "Estás cerca y con la mano sobre la mesa", dice. Esto ha sido posible gracias a los avanzados modelos de lenguaje de OpenAI.

Esta sería la primera colaboración entre una compañía y OpenAI para potenciar las capacidades de un robot humanoide como es el Figure 01. El cual pretende ser una herramienta comercial que pueda funcionar en entornos comerciales de distinta índole. De hecho, algunas de las demostraciones que Figure ha realizado con su robot muestran al dispositivo llevando a cabo ciertas tareas en almacenes.

Brett Adcock, fundador y CEO de Figure, explicó junto a la publicación del vídeo del Figure 01 algunas de las características de su robot humanoide. La unión entre OpenAI y su empresa ha dado lugar a conversaciones con humanos "en redes neuronales de un extremo a otro".

En un hilo, Adcock revela que la tecnología de OpenAI proporciona razonamiento visual y comprensión del lenguaje, y que las redes neuronales de Figure ofrecen "acciones robóticas rápidas, de bajo nivel y diestras". Afirma que en el metraje no hay teleoperación y que no hay truco; la filmación se hizo a velocidad normal, y se hizo en una única toma.

La clave de este impresionante resultado radica en la plétora de cámaras y sensores equipados en la parte superior del Figure 01. "Las cámaras integradas en el Figure 01 se alimentan de un gran modelo de visión y lenguaje (VLM) entrenado por OpenAI. Las redes neuronales del robot toman imágenes a 10 Hz a través de cámaras en el robot, y luego la red neuronal genera acciones de 24 grados de libertad a 200 Hz", dice el CEO.

[El robot humanoide que se adelanta al Tesla Bot: aprende de los humanos para mandarlos al paro]

El anterior investigador de Google DeepMind y actual responsable de IA de Figure, Corey Lynch, ha explicado con más detalle lo que se ve en esta demostración. Afirma que el robot de la compañía puede desde describir su experiencia visual hasta "planificar acciones futuras", pasando por reflexionar sobre su memoria o explicar su razonamiento verbalmente.

Para ello, Figure usó imágenes de las cámaras del robot y transcribieron texto del habla capturada por micrófonos integrados en el robot a un gran modelo multimodal, el ya mencionado VLM de OpenAI. Este procesa toda la historia de la conversación, "incluyendo imágenes pasadas, para generar las respuestas lingüísticas" presentes en el metraje. Estas se responden al ser humano a través de un sistema de texto a voz.

Es el modelo, por lo tanto, es el encargado de decidir "qué comportamiento de bucle cerrado aprendido ejecutar en el robot para cumplir un comando determinado", relata Lynch. Conectar su robot a esta clase de modelos abre ciertas puertas, detalla el experto, como la capacidad de describir entornos, usar razonamientos con sentido para tomar decisiones o traducir "solicitudes ambiguas y de alto nivel como 'tengo hambre'".

Este es todo un logro si tenemos en cuenta que el acuerdo entre Figure y OpenAI lleva estando vigente apenas unas semanas. Según relató el CEO de Figure, la gran intención final es la de entrenar un modelo de carácter mundial para operar robots humanoides "al nivel de mil millones de unidades". Algo que podría no tardar demasiado en verse.