Fotomontaje del logo de OpenAI con Tim Cook, CEO de Apple. Omicrono

El futuro de Siri ante un acuerdo de Apple con OpenAI: la fusión con ChatGPT 4o y todo lo esperable de WWDC

Google y OpenAI han medido sus fuerzas esta semana con importantes anuncios, ahora le toca a Apple revelar como va a llevar la IA a sus iPhones.

17 mayo, 2024 13:00La inteligencia artificial se está fusionando con los dispositivos. Esta tecnología pretende simplificar la relación entre las personas y sus móviles, tablets, ordenadores y demás equipos. Otros fabricantes han iniciado ya este camino, mientras Apple se reserva para dar el gran salto en junio, cuando posiblemente anuncie un acuerdo con OpenAI o con Google. Precisamente las dos empresas que han protagonizado esta semana los dos grandes avances en inteligencia artificial.

OpenAI ya ha lanzado a todo el mundo su nuevo chatbot, ChatGPT 4o capaz de comunicarse por voz con gran fluidez y ayudar en innumerables funciones, desde traducción simultánea a tratamiento de gráficas. Google por su parte, presentó un día más tarde una larga lista de novedades en IA generativa para Gemini y Project Astra, algunas muy similares a las que propone su rival.

Nunca se había mencionado el término IA tantas veces como en las últimas presentaciones y Apple va por el mismo camino. Hace meses que se rumorea que Apple estaría en conversaciones con ambas para integrar su tecnología en los iPhone, mientras desarrolla su propia IA (con OpenAI es con quién parece tener un acuerdo más firme de momento). Con motivo de esta convulsa semana, el fabricante de móviles se ha animado a adelantar ciertas funciones de accesibilidad que llegarán con iOS 18, como una pista de lo que depara el futuro.

El futuro de Siri

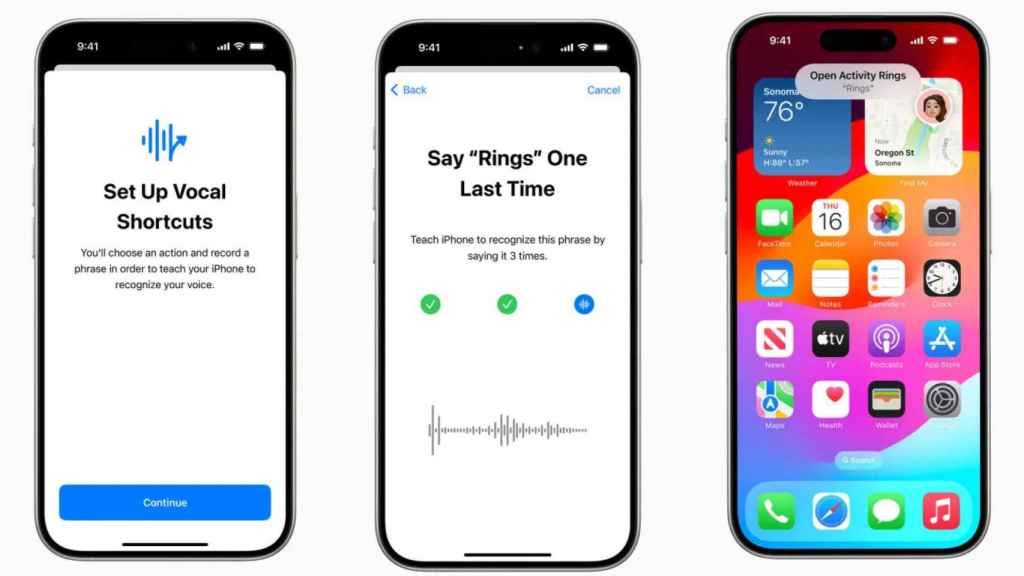

Además de poder controlar con los ojos el dispositivo, esta semana Apple ha anunciado otras novedades (estarán disponibles a final de año) como la que permite configurar indicaciones de voz personalizadas para determinadas acciones sin tener que llamar a Siri, su asistente. La empresa ha puesto de ejemplo "Anillos", con la que se desplegarían los anillos de actividad.

Se espera que Siri y la forma de interactuar con el móvil cambie por completo con la llegada de la IA. De frases preconfiguradas, debería responder a una conversación más parecida a la que se tiene con otra persona. Similar a la demostración de OpenAI de este lunes, donde los presentadores interrumpían a ChatGPT mientras le hacían toda clase de preguntas y la IA respondía creando hasta diferentes tonos de voz para contar un cuento.

Acciones personalizadas en iPhone Omicrono

La actualización gratuita a GPT-4o está disponible de momento en sus versiones web para móvil y escritorio. Permite cargar archivos para analizarlos y resumirlos, incluso se pueden archivos directamente desde Google Drive y Microsoft OneDrive; utiliza las cámaras del terminal para describir o trabajar con las imágenes; traduce de un idioma a otro en tiempo real, entre otras muchas opciones.

Si Siri se convierte en un asistente con estas capacidades, no solo revolucionará el uso del iPhone, también es de esperar que impacte en las Visión Pro de Apple. Meta ya está planteando la creación de unos auriculares con cámaras para que la IA pueda oir y escuchar lo mismo que el usuario y ayudarle en consecuencia.

Procesamiento en local y nube

Si se confirma el acuerdo entre Apple y OpenAI, puede que este sea la futura Siri. Para ello, se plantea otra duda, la forma de integrar estas novedades que requieren un gran peso de computación en los iPhone sin perder rendimiento. Apple, aunque actúa de forma precavida hasta ahora con la IA, no es nueva en este mundo, desde el lanzamiento del chip A11 Bionic, ha contado con una unidad de procesamiento neuronal en sus dispositivos, el Neural Engine.

La aplicación de ChatGPT en iPhone Omicrono

Su último lanzamiento, los iPads, llegaron con el chip M4. La CPU de este nuevo procesador ofrece un rendimiento hasta 1,5 veces más rápido que el iPad Pro con chip M2. Por su parte, el Neural Engine le permite al iPad Pro realizar 38 billones de operaciones por segundo con lo que le convierten en una máquina supercapaz de procesar IA en el dispositivo y aprovecharlo en aplicaciones como nunca antes. Además, la verdadera magia del chip está en su eficiencia energética, pues utiliza sólo la mitad de potencia que el M2.

Esta capacidad de procesamiento debería poder hacerse cargo de ejecutar las tareas de IA en local, para evitar que los datos privados de los usuarios se manden a un centro de datos o nube, como ocurre cada vez que se usa Gemini o ChatGPT. Para Apple la privacidad es uno de sus estandartes y la IA no puede ir en contra de ello.

Tim Cook, CEO de Apple, en España. Omicrono

Tim Cook, llegó a afirmar que él personalmente utilizaba ChatGPT, no sin olvidarse de aclarar que debían resolverse una serie de problemas. Es posible que en el acuerdo, ambas compañías hayan llegado a una solución para proteger a los usuarios de iPhone. En junio deberán aclarar si el uso de esta AI en el iPhone supone entrenar al modelo de lenguaje.

Aún así, en las últimas semanas, entre los numerosos rumores que circulan al respecto, se ha hablado de la posibilidad de colocar sus chips M2 Ultra en centros de datos para ejecutar tareas de IA avanzadas, para que sus dispositivos se centren en procesar las tareas más sencillas.