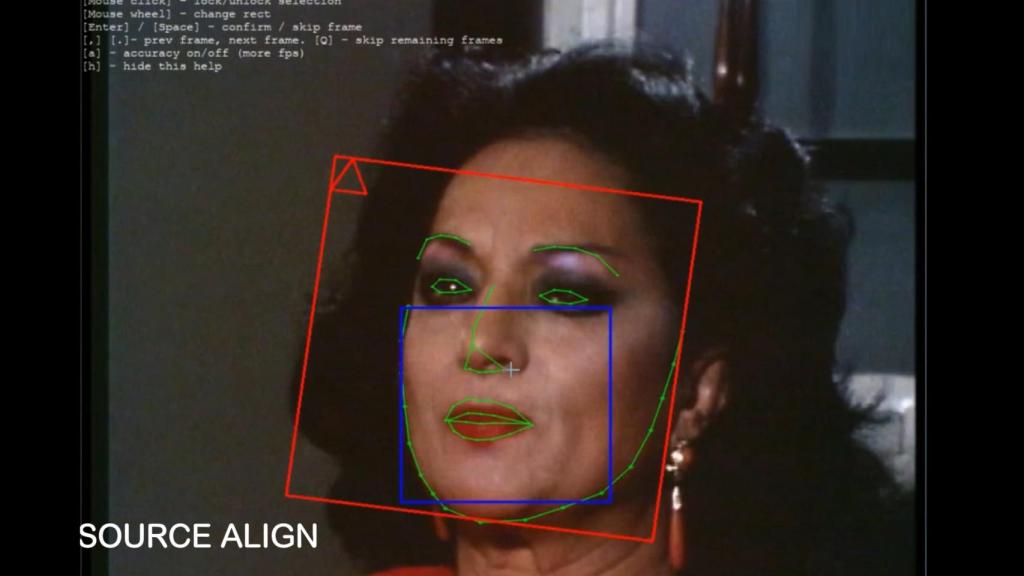

Deepfake de Lola Flores Omicrono

Los 'deepfakes' empiezan a protagonizar las leyes de IA de todo el mundo en un intento por mitigar sus posibles daños

Europa, Estados Unidos o China son algunas de las regiones que han avanzado en la regulación de estas herramientas.

2 enero, 2023 01:59Casi a principios de año, un estudio realizado por investigadores de la Universidad de Lancaster y de la Universidad de California revelaba que los humanos son incapaces de distinguir los rostros generados artificialmente de los reales. Además, el informe señalaba que los falsos generan un mayor nivel de confianza que los verdaderos.

Sophie J. Nightingale y Hany Farid, los responsables de esta investigación, concluyeron que las imágenes de personas generadas sintéticamente ya no solo son altamente fotorrealistas, sino que son prácticamente indistinguibles.

Gran parte de este nuevo escenario está relacionado con el avance que han sufrido este tipo de herramientas en los últimos años, que se han perfeccionado de forma notable y, a la vez, se han democratizado, estando disponibles para casi cualquier usuario con acceso a internet.

Esto ha hecho que proliferen en internet contenidos (vídeos o imágenes) falsificados de una persona que se hacen pasar como genuinos con el objetivo de desinformar, defraudar o difamar y que, normalmente, se realizan a través de herramientas impulsadas por la inteligencia artificial. Los conocidos popularmente como deepfakes.

Además de las consecuencias nefastas de su utilización para fines delictivos, los expertos también advierten que esta situación puede generar que, si se tiene en cuenta la posibilidad de que cualquier imagen o vídeo puede haber sido fabricado artificialmente en un mundo eminentemente digitalizado, la autenticidad de todo tipo de contenidos podría ponerse en duda en el momento en el que se considere inconveniente, lo sea o no.

Este fenómeno ha hecho saltar las alarmas de los organismos legislativos de todo el mundo, que han empezado a plantearse cómo imponer salvaguardas que ayuden a mitigar los daños que puedan derivarse de la aplicación de esta tecnología sin paralizar la innovación asociada.

De hecho, expertos como el presidente de We the humans, Juan Ignacio Rouyet, ya avanzaban a principios de año la necesidad de desarrollar un organismo externo que se dedique a auditar a las compañías que utilizan la inteligencia artificial para comprobar que informan a sus usuarios de que la están aplicando y les garantizan una serie de controles.

"Esto no va a evitar la innovación, lo que va a hacer es favorecerla de manera responsable, ética", precisaba.

En este sentido, señalaba la necesidad de buscar fórmulas de trazabilidad que faciliten la investigación, así como unas normas del juego que limiten los daños, ya que, actualmente, no existen reglas fijas, sino que se encuentran en proceso de creación.

Rouyet apuntaba que, cuando aparezca esta normativa, esta tecnología se democratizará bajo cierto control, lo que asegurará su uso razonable.

Un entorno "más transparente, seguro y fiable" en Europa

A mediados de 2021, el Parlamento Europeo ya mostraba sus preocupaciones respecto a una nueva generación de contenidos digitales manipulados y su posible uso indebido.

Así, el organismo publicó en estas fechas un informe en el que evaluaba los aspectos técnicos, sociales y normativos de los deepfakes y destacaba su rápido desarrollo y evolución en un contexto cambiante. En él, daba cuenta de los riesgos asociados, tanto de naturaleza psicológica como financiera, y el amplio rango de impacto que pueden tener.

El documento ya anticipaba cinco dimensiones en las que los legisladores pueden actuar para prevenir y abordar los daños adversos de este tipo de publicaciones sin limitar su potencial y que se pueden incluir en futuros reglamentos como el de inteligencia artificial de la UE o la Ley de Servicios Digitales (DSA, por sus siglas en inglés).

El primero de ellos, relacionado con la IA, es un marco legislativo en el que la Unión Europea está trabajando para unir todas las normas relativas a esta tecnología y con el que pretende controlar los posibles riesgos derivados e impulsar las oportunidades derivadas.

Mientras, el segundo, la DSA, que entrará en vigor a principios de 2024, tiene como objetivo principal obligar a las plataformas online (entre las que se incluyen las redes sociales) a moderar sus contenidos, retirar los que sean ilegales y hacer los algoritmos más transparentes.

En este contexto, hace unos meses, la Comisión Europea publicó el nuevo Código de buenas prácticas en materia de desinformación, basado en el de 2018, que establece compromisos por parte de las plataformas y las empresas en la lucha contra la desinformación en busca de un entorno online "más transparente, seguro y fiable".

Según apunta este organismo, junto a la Ley de Servicios Digitales y la próxima legislación sobre transparencia y segmentación de la publicidad política, esta normativa "constituye un elemento esencial del conjunto de instrumentos de la Comisión para luchar contra la desinformación en la UE".

Este documento, respaldado por 34 signatarios, entre ellos, Meta, Google, Twitter, TikTok o Microsoft, tiene entre sus compromisos "contemplar nuevos comportamientos de manipulación" como cuentas falsas, bots o "ultrafalsificaciones profundas malintencionadas que difunden desinformación".

Desde su anuncio, a mediados de 2022, los mandatarios han tenido seis meses para cumplir las medidas suscritas y, a principios de 2023, deberán presentar a la Comisión sus primeros informes de ejecución.

Pautas para el uso correcto en China

Por su parte, el Gobierno chino, también ha mostrado su preocupación en varias ocasiones por el empleo de estas técnicas.

De hecho, la Cyberspace Administration de China, el organismo encargado de estos asuntos, ha emitido una serie de pautas, que se prevé que entren en vigor en 2023, sobre cómo hacer deepfakes de manera correcta, entre ellas, la prohibición de su creación sin el permiso del sujeto al que hacen referencia, de cualquier cosa que pueda considerarse contraria al interés nacional o que genere información ilegal y dañina.

Además, la regulación contempla la revisión de los modelos de inteligencia artificial o de machine learning y de los algoritmos de forma regular para garantizar la seguridad de los datos recopilados.

Las reglas también señalan como requisito que los usuarios se registren con sus nombres reales a la hora de acceder a algún tipo de herramienta relacionada.

A pesar de ello, y bajo esas premisas restrictivas, el Ejecutivo chino se ha mostrado a favor, asimismo, de promocionar estas tecnologías en aplicaciones como los chatbots, donde precisa que deben marcarse como "creaciones digitales".

Hasta un año de cárcel en Estados Unidos

Por su parte, en Estados Unidos este debate viene de largo y, de hecho, fue en 2019 cuando entró en vigor en el estado de Virginia una ampliación de una ley que perseguía la "pornografía no consensual" donde se incluyó la definición de los deepfakes pornográficos.

Así, la difusión de falsos desnudos "con la intención de coaccionar, acosar o intimidar" a otra persona podrá suponer hasta un año de cárcel y 2.500 dólares de multa.

A este se suma otro cambio legislativo que se aprobó a la par en el estado de Texas donde se abordaban las manipulaciones digitales con fines políticos. Esta normativa busca evitar la difusión de contenidos simulados con fines de manipulación del electorado.

También, en Estados Unidos están surgiendo iniciativas que buscan ayudar a identificar las falsificaciones, por ejemplo, Deep Fake Detector Challenge, impulsada por Meta y Microsoft, junto a la Universidad UC Berkeley, un proyecto para crear una IA capaz de detectar los vídeos manipulados.