Pongamos que vive usted en una ciudad donde circulan 1.000 coches autónomos que se coordinan entre sí para no provocar accidentes de tráfico. Pongamos que un pirata informático accede a 10 de ellos y cambia su configuración para que envíen información falsa a otros vehículos. Y, como resultado, todo el sistema se viene abajo.

Es uno de los problemáticos escenarios que plantea el investigador español Eduardo Castelló Ferrer, asociado al MIT Media Lab, al MIT Connection Science y al Laboratorio de investigación de Inteligencia Artificial de la Universidad Libre de Bruselas, en su investigación. Castelló ha desarrollado un método para evitar que algo así pase, y lo publica esta semana en la revista Science Robotics.

Con su modelo de cooperación informática encriptada, el investigador demuestra -una vez más- que privacidad y seguridad no son incompatibles. Su método separa la verificación de datos de los datos en sí, de modo que cualquier grupo de agentes -robots, algoritmos, humanos…- pueda cooperar con un mismo fin sin conocer su identidad.

“Puedes encriptar grandes misiones sin que los implicados sepan quiénes son los otros agentes ni el objetivo final, lo que permite la colaboración de gente que normalmente no colaboraría”, asegura Castelló en entrevista con D+I.

De esa forma se preserva la privacidad, ya que no es necesario revelar ningún tipo de información privada sobre los individuos que componen el grupo ni los datos necesarios para llevar a cabo la tarea. ¿Cómo lo hace? Usando los llamados ‘árboles Merkle’, uno de los componentes fundamentales de la tecnología blockchain.

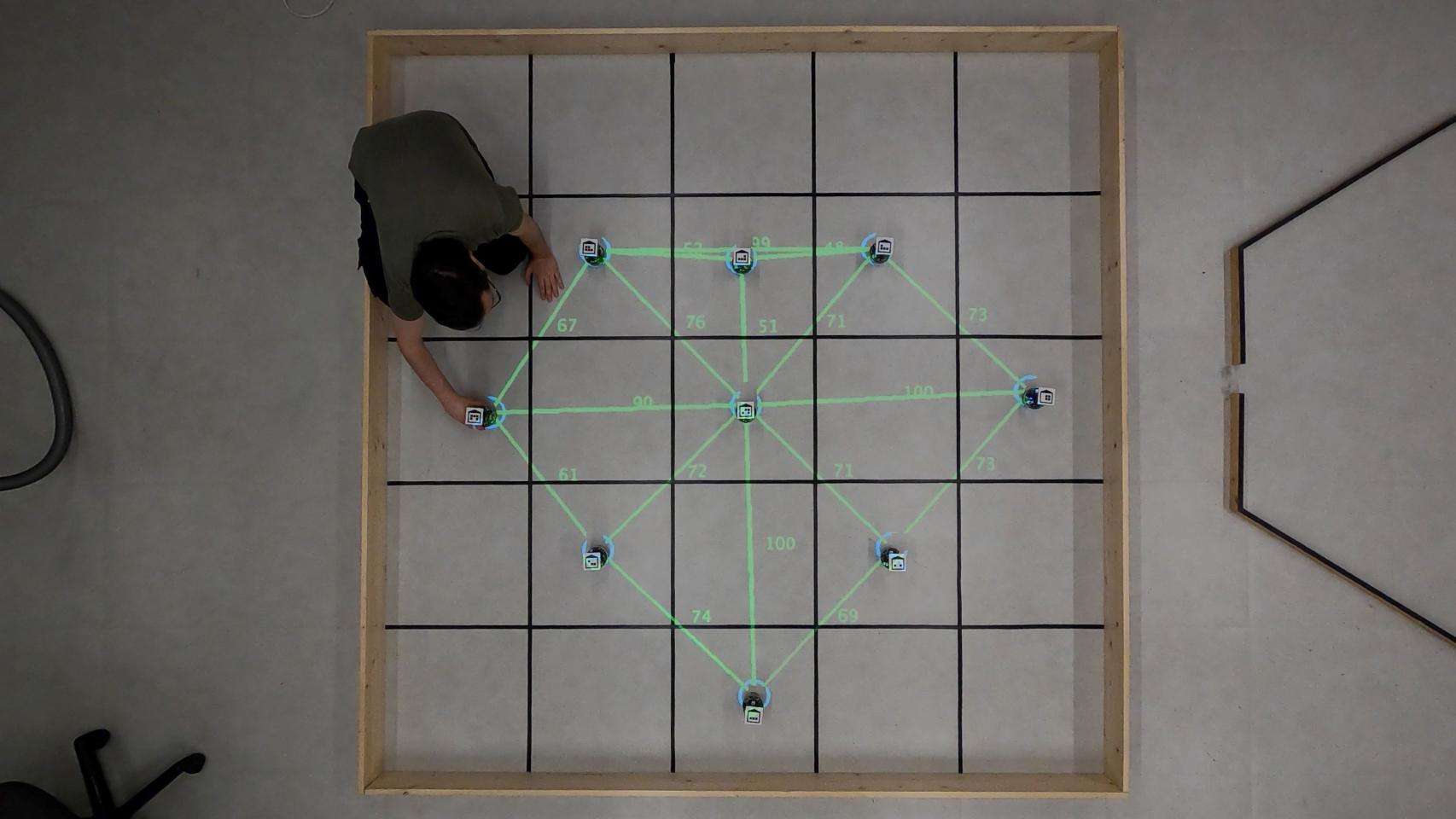

Cooperación segura y secreta en enjambres de robots: búsqueda de alimento (robots reales).

Cooperación segura y secreta en enjambres de robots: formación de laberintos (robots reales).

Claves criptográficas

Ese tipo de estructura -los árboles Merkle- puede contener información criptográfica . “Puedes generar un plano de lo que quieres hacer e introducirlo en ella como si fueran pequeñas piezas de lego”, explica el investigador.

Al estar encriptado el árbol, las ‘hojas’ que lo componen no son datos ni secuencias de tipo “si pasa X, entonces Y”. Son unas claves criptográficas -llamadas ‘hash’- que sirven para validar operaciones pero que no contienen información sobre la operación en sí. “Es como comprobar que un ingrediente es parte de una receta, sin necesidad de saber cómo se usó en qué momento, ni cuál es el plato final. Una especie de firma digital de la operación”, dice Castelló.

Mediante el intercambio de estas pruebas criptográficas, los agentes pueden demostrar a sus compañeros su integridad -que han realizado ciertas acciones o que conocen o poseen cierta información- sin que estos conozcan su identidad. No tienen que confiar ciegamente entre sí ni conocer la misión global.

Es una teoría que Castelló ya comprobó en simulaciones de laboratorio en 2019 y que durante el último año ha probado con robots reales. “Siguiendo esta metodología, son capaces de realizar operaciones muy complejas sin saber cuál es el objetivo final”, señala. Ello protege de ciberataques a los robots o agentes implicados o, como mínimo, complica enormemente el trabajo de los hackers maliciosos.

Robots usados en los experimentos

“Este modelo permite que cualquier ataque externo a uno o varios de los robots no haga fallar el propósito final del trabajo. Incluso se podrían incluir robots redundantes que aseguren el desempeño final por si se produjeran dichos ataques externos”, comentan los expertos en blockchain Francisco Luis Benítez, investigador en Ciberseguridad y Cambio Digital de la Fundación I+D del Software Libre Fidesol y Montse Guardia, directora de la asociación española de blockchain Alastria.

“Es un tipo de criptografía ligera que permite trabajar con tiempos de ejecución muy altos y transacciones rápidas y eficaces dentro del esquema propuesto”, comentan Benítez y Guardia. Apuntan que el trabajo de Castelló ofrece “una solución práctica y ligera”. “Sin duda abre nuevas perspectivas y opciones futuras”, añaden.

Contra la corrupción o la desinformación

Castelló señala múltiples usos posibles de su modelo, más allá de lo obvio, como pueden ser las misiones secretas de alta seguridad. Por ejemplo, para gestión de desastres o la vigilancia de infraestructuras críticas, contra la corrupción o la desinformación o para auditar software.

“La corrupción es la disociación entre información local y global. Si una empresa de ventanas sabe que hay un concurso público para construir un gran edificio y van a contratar a las dos únicas empresas de ventanas de la zona, se puede aliar con otra empresa para pactar un precio más elevado", explica.

"Con nuestro sistema esas empresas no sabrían cuál es el objetivo global ni cuántas compañías pueden licitar, por lo que no podrían compincharse para estafar”, añade.

En zonas con conflictos diplomáticos como Gaza donde se necesita la cooperación de partes que no trabajarían juntas -como palestinos e israelíes- se podría usar este método para hacer que ambos participen sin saber quién más está implicado”, comenta también el investigador.

En los experimentos, los robots pueden interconectarse de infinitas maneras para intercambiar información. © MIT Media Lab - IRIDIA

También puede servir a medios de comunicación o a empresas para probar que tienen una información sin difundirla. Por ejemplo, D+I podría acreditar que ha accedido, visto o tiene cierto documento sin publicarlo ni revelar sus fuentes. O un particular o empresa podría demostrar a un potencial cliente que tiene lo que este busca sin necesidad de enviárselo de antemano. Así las dos partes pueden colaborar sin necesidad de tener que confiar.

Aplicado al mundo de la auditoría algorítmica, se podrían inspeccionar sistemas de inteligencia artificial en busca de sesgos sin acceder a los datos. Quien la ha desarrollado simplemente podría probar que ha usado una cifra suficiente de inputs diversos en términos de género, raza, religión, edad, nivel de renta o cualesquiera variables a considerar en la operación.

En una empresa como Coca Cola, se podrían usar robots cooperativos sin revelarles la receta secreta, de modo que si alguien piratea alguno o varios de esas máquinas no pueda conocerla. Es una forma de preservar su propiedad intelectual.

El método también sirve para proporcionar incentivos que motiven a la gente a hacer algo sin saber el propósito final. Por ejemplo, un ayuntamiento puede querer reducir la compra online para fomentar el gasto local y para ello premiar acciones de compra de proximidad sin revelar necesariamente el objetivo final (aunque en este caso pueda ser obvio).

El reto de la instantaneidad

La limitación de la propuesta de Castelló se encuentra en escenarios en los que las capacidades en tiempo real sean importantes para cumplir la misión. Por ejemplo, coordinación de movimiento y prevención de colisiones. Los robots necesitan descubrir la combinación correcta de ‘hashes’ para ejecutar una tarea, y ello puede hacer imposible garantizar que la completen en un tiempo determinado.

Castelló reconoce dichos límites en su estudio, algo que Benítez y Guardia también señalan. “Uno de los grandes retos tecnológicos es cómo segurizar los datos en bruto producidos en tiempo real para que sean verificados y no alterados a priori”, afirman.

Por ejemplo, si se modifican los datos de pH o humedad en un plantación y no se percibieran como una anomalía, podría llevar la cosecha a la ruina. También se podría convertir un vehículo autónomo en un arma dispuesto a atropellar peatones a altas velocidades, ilustran los Benítez y Guardia.

En cuanto al consumo energético, el investigador comenta que no lo ha calculado, pero a juzgar por la cantidad de memoria y comunicación que necesitan los robots- “muy limitados en capacidad de batería, CPU, etc.”- cree que una misión tipo requerirá pocos recursos.

Futuro robótico

Castelló cree que la creciente atención que está atrayendo la robótica cooperativa, unida a la necesidad de sistemas automatizados sin contacto hecha obvia durante la pandemia, traerá un futuro en el que múltiples infraestructuras de este tipo coexistirán en un mismo lugar.

“La robótica distribuida tiene aplicaciones variadas y muy interesantes, desde sistemas de reparto sin humanos hasta autopistas”, afirma el investigador. Cree que tanto entidades públicas como privadas desplegarán este tipo de infraestructura en áreas urbanas, de desastres, en entornos industriales o en campos de batalla para misiones secuenciales.

Con su método, podrían hacerlo sin exponer datos sobre sus procesos internos, objetivos y organizaciones. Lo próximo que se plantea es extender su uso sistemas donde la cooperación se realice entre agentes mixtos humano-máquina, a cadenas logísticas y escenarios similares donde se requiere coordinación pero el objetivo general de la misión debe permanecer en secreto. Privacidad y seguridad, todo al mismo tiempo.

Noticias relacionadas

- Análisis en profundidad de la Carta de Derechos Digitales: buenas intenciones, preocupantes retrocesos

- La robótica industrial contiene el impacto de la covid en 2020 gracias al impulso de China

- La Carta de Derechos Digitales de Pedro Sánchez, al detalle: de la neutralidad de la red a la igualdad de género online