La ética, ¿un desafío demasiado grande para Google?

La tribuna

La ética, ¿un desafío demasiado grande para Google?

La ética es la rama de la filosofía que estudia la conducta humana: qué es correcto o incorrecto, bueno o malo, moral o inmoral. También, la forma del mejor vivir: la virtud, la felicidad o los asuntos del deber. La ética más contemporánea se suele plantear en varios niveles. La meta-ética estudia el origen, naturaleza y significado de los conceptos éticos; la ética normativa, busca normas o estándares para regular la conducta humana; y la ética aplicada examina controversias éticas concretas, como por ejemplo las que están surgiendo ahora con la inteligencia artificial (IA).

La ética es una disciplina que siempre ha estado próxima al centro de gravedad de la filosofía y, por tanto, de las humanidades. Era asunto mucho más de humanistas y científicos que de economistas, tecnólogos o empresarios. La Stanford Encyclopedia of Philosophy -en Stanford son muy aficionados a la visión utilitarista- describe una ética específica de los negocios (business ethics) que se ocupa del estudio de las dimensiones éticas específicas en organizaciones productivas y comerciales, incluyendo análisis éticos de producción, distribución, comercialización, venta o consumo de bienes y servicios (incluida la Internet Research Ethics). O sea, que las empresas deberían incluir la business ethics dentro de sus guías de buenas prácticas.

Sin embargo, sobre todo las grandes corporaciones, se usan los temas éticos como un simple apéndice de áreas como las relaciones públicas, de imagen, o de lo que llaman "responsabilidad social corporativa". Incluso hay entidades que han hecho de la ética y las humanidades relacionadas un negocio en sí mismo, en general, sirviendo a grandes corporaciones y empresas.

Filosofía y ética, disciplinas imprescindibles para la IA

La ética y las humanidades, durante las últimas décadas, han estado en segundo plano. Esto ha permitido, incluso, que algunos descerebrados dirigentes políticos y de los planes de educación de nuestro país, recientemente, eliminaran durante un tiempo la filosofía del Bachillerato. Así nos ponían en dirección contraria a las primeras universidades del mundo, que se están restructurando internamente para reconectar la vanguardia de la tecnología con las humanidades y la filosofía, algo que se ha vuelto imprescindible para el desarrollo de la inteligencia artificial.

Por otra parte, resulta curioso que los temas de masiva elusión fiscal y uso de paraísos fiscales por empresas globales, manifiestamente injustos e "inéticos" (Stallman), no generen el menor debate sobre su ética. Las grandes multas de la Unión Europea por estas prácticas solo son pinchazos de alfiler en la piel de paquidermo de los gigantes tecnológicos globales.

El ejemplo del Consejo de Ética para la IA de Google

Los citados gigantes tecnológicos globales están haciendo, en sus servicios actuales basados en internet, un uso intensivo de algoritmos de inteligencia artificial que plantean, obviamente, nuevos dilemas, problemas e incertidumbres a los usuarios de la tecnología de sus empresas.

El caso actual más reciente y significativo es el de Google, que ha decidido abordar estos nuevos y complejos dilemas que genera la inteligencia artificial basándose en su gran impacto en las vidas de los usuarios. Aunque ofrece múltiples servicios, solo observando las cifras de sus tecnologías de búsqueda (que fueron su origen), podemos ver que implican una carga social enorme. Google es usado ahora mismo por 1.170 millones de personas que realizan 100.000 millones de búsquedas cada mes (2,3 millones cada segundo). Esas personas acceden al buscador y otros servicios en 150 idiomas desde 190 países distintos.

Para gobernar esa maquinaria y atender esa relación con tantos millones de personas es imprescindible la inteligencia artificial. Tantas gente repartida por todo el globo vive circunstancias personales, políticas, sociales y culturales muy diferentes, lo que da lugar a múltiples cuestiones relacionadas con la condición humana. Cuando los seres humanos y la IA entran en contacto, es posible e incluso probable, que se produzcan resultados inesperados y/o no deseados.

Su interacción con las tecnologías de IA tiene todo tipo de implicaciones, tanto por usos positivos de la tecnología, como por usos malignos e incluso infames de ella. El incidente del reciente asesinato múltiple en Nueva Zelanda transmitido en directo por streaming por YouTube (que pertenece a Google), mostró la incapacidad de su servicio para impedir su transmisión y es ejemplo flagrante de hasta donde pueden llegar trágicamente las cosas.

Uno pensaría que Google, una empresa capaz, por ejemplo, de resolver el desafío tecnológico de cartografiar el planeta entero para su servicio Google Earth, sería capaz de asumir casi cualquier reto. Como el de dar respuesta a los dilemas éticos que lógicamente iban a surgir al usarse sus tecnologías en servicios que afectan a tantas personas.

Segura de ello, la semana pasada, Google anunció, como una cosa más, la creación de su Consejo Asesor Externo de Tecnología Avanzada (ATEAC), cuyo propósito es “abordar los nuevos y complejos desafíos sociales y éticos que podrían surgir durante el desarrollo y usos con los usuarios de las tecnologías de IA”, y generar puntos de vista independientes y útiles a la empresa para resolver dichos desafíos.

Pero los retos éticos han resultado ser mucho más complejos que los tecnológicos, a los que ya estaba acostumbrada la empresa. En diseño, se suele decir que “un dromedario es un galgo diseñado por un comité”. Pues bien, el camino de crear un comité externo para abordar estos nuevos desafíos parece que está encontrando muchas dificultades y está haciendo buena la frase del dromedario.

Ya en la elección de miembros de ese consejo han surgido dificultades. El economista de la conducta e investigador de la privacidad Alessandro Acquisti, elegido el primero para formar parte de ATEAC, finalmente no aceptó, y ha decidido hacer públicas en Twitter sus razones: “Aunque me dedico a la investigación sobre cuestiones éticas clave en equidad, derechos e inclusión en la IA, no creo que este sea el ‘foro’ adecuado para participar en este importante trabajo”.

En pocos días surgieron nuevos tropiezos: empleados de Google presionaron para la expulsión de Kay Cole James, presidente de la Heritage Foundation, del ATEAC por sus declaraciones que consideraban "antitrans, antiLGBTQ y antiinmigrantes". La miembro del propio comité Joanna J. Bryson también se ha sumado a las críticas.

La idea de dejar en manos de un comité externo los temas relacionados con la ética se puede interpretar de dos maneras. Una, se puede pensar que, desde fuera, sus miembros serán más independientes a la hora de opinar y proponer medidas. Pero, otra defiende que los temas éticos no se traten como algo esencial, dentro del ‘núcleo duro’ de la empresa.

Han comenzado a surgir, por otra parte, numerosos términos relacionados, esta vez no con funcionalidades tecnológicas, sino con aspectos de la condición humana: sesgos algorítmicos impropios en relación a género, raza, desigualdad, etc. Google ya había tenido que enfrentarse a problemas similares. Por ejemplo, tuvo que eliminar los pronombres de género de su funcionalidad de ‘composición inteligente’ en Gmail, porque sus algoritmos de software no predecían correctamente el género de la persona a la que se respondía. Y hace un tiempo, Google tuvo que actuar y dar explicaciones cuando Google Photos empezó a etiquetar imágenes de personas negras como gorilas. Y también está en discusión si sus nuevas tecnologías de búsqueda favorecen o no diversos tipos de censura.

Google no es el único que se enfrenta a esta situación. Les ocurre a otros gigantes tecnológicos como Amazon, con su tecnología de reconocimiento facial que solo funciona bien con personas blancas, o con su herramienta de reclutamiento, cuyo software estaba sesgado en contra del género femenino.

Se está demostrando que hay empresas tecnológicas usando algorítmica injusta que, como dice David Casacuberta, hay que combatir. Pensar que las cuestiones éticas emergentes de sus servicios, que involucran a miles de millones personas, se pueden resolver simplemente nombrando un comité externo está resultando ser algo muy insuficiente.

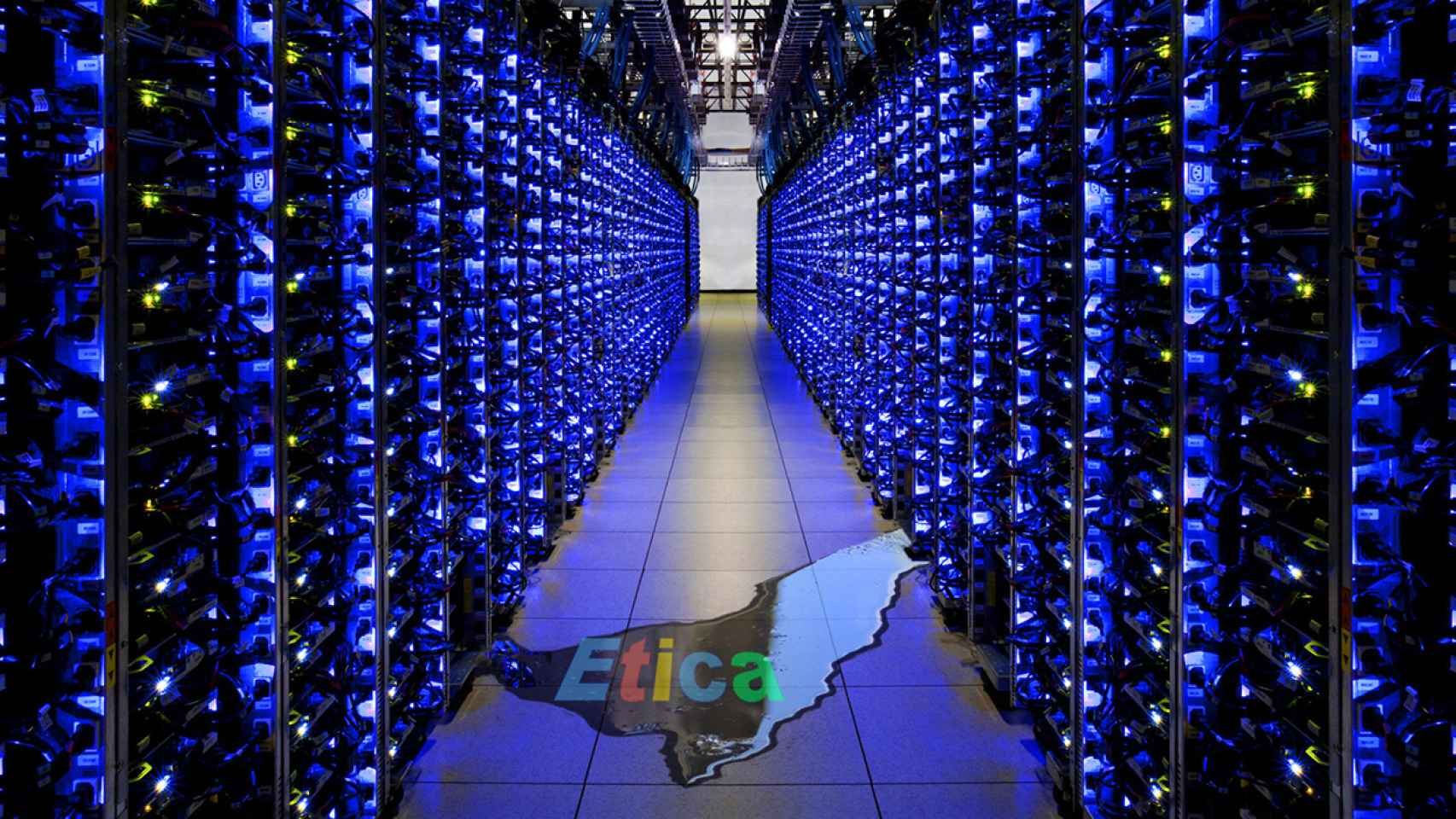

Los gigantes que han triunfado al abordar enormes retos tecnológicos globales, en cambio, están haciendo aguas por subestimar el enorme reto de los nuevos problemas relacionados con la ética. ¿Acaso el resolver las nuevas cuestiones éticas que surgen en la relación entre humanos y máquinas de la inteligencia artificial es un desafío muy por encima de las actuales capacidades de los todopoderosos gigantes tecnológicos? Hoy por hoy parece que sí.