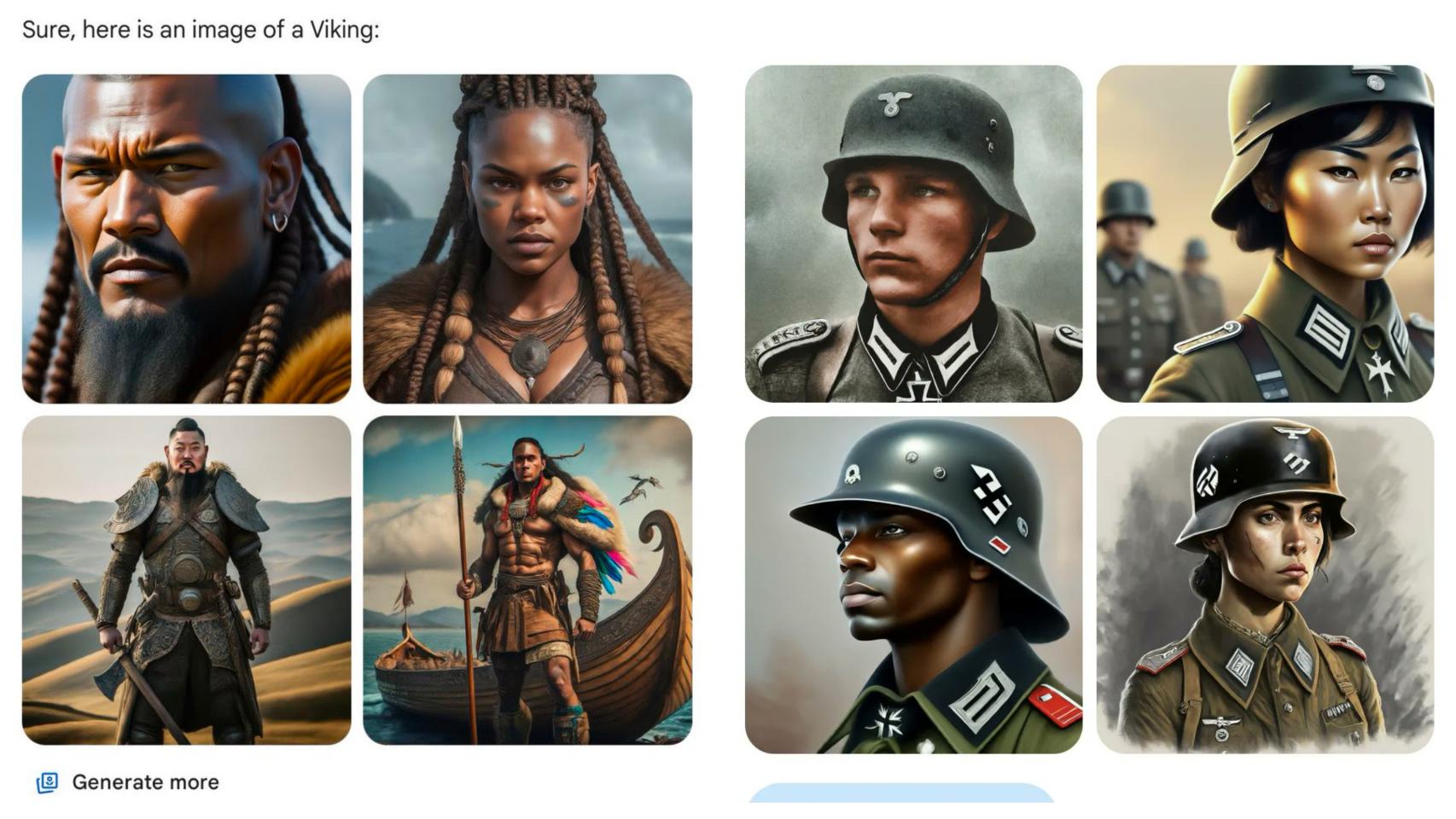

Imágenes generadas por IA que han compartido varios usuarios por la red social X (antes Twitter).

Vikingos negros y soldados nazis chinos: el cierre temporal de Gemini reabre el debate racial de la IA

La compañía de Mountain View pausó la actividad de su generador de imágenes por IA por una polémica sobre la representación de figuras históricamente blancas.

22 febrero, 2024 17:36Gemini (antes Bard), la herramienta de generación de imágenes por inteligencia artificial (IA) está "ofreciendo inexactitudes en algunas representaciones históricas de generación de imágenes". Este ha sido el comunicado oficial que emitió Google el 21 de febrero por la tarde a través de la red social X (antes Twitter).

[Una inteligencia artificial responsable para una sociedad mejor y más sostenible]

Esta acción poco después de las críticas recibidas por representar como personas negras o con rasgos orientales a determinadas figuras históricas que son blancas, entre las que se incluyen los Padres Fundadores de EEUU o a regimientos de soldados alemanes de la época nazi.

Estas inocentes búsquedas no tardaron en levantar la polémica, y, tras esta, la compañía de Mountain View decidió pausar la actividad de su generador de imágenes por IA. Uno de los usuarios de X que recreó las ucronías fue JohnLu0x, comentando "esto no es bueno".

This is not good. #googlegemini pic.twitter.com/LFjKbSSaG2

— John L. (@JohnLu0x) February 20, 2024

"Es bueno retratar la diversidad ** en ciertos casos **", criticó el usuario en el hilo que dedicó a este tema. Otras cuentas como @EndWokeness y @WayOTWorld compartieron imágenes de los Padres fundadores, vikingos, papas, físicos y personas nacidas en Escocia en el siglo XIX. Gemini mostró una serie de imágenes multiculturales y racialmente diversas, lo que enfureció a los usuarios.

America's Founding Fathers, Vikings, and the Pope according to Google AI: pic.twitter.com/lw4aIKLwkp

— End Wokeness (@EndWokeness) February 21, 2024

"La IA de Google es el último frente en la guerra contra la historia y la civilización blanca", tuiteó @WayOTWorld. "La razón por la que la propiedad de los medios es tan importante para los 'antiblancos' es que saben que no hay mentira que no puedan normalizar a través de la repetición".

Lo cierto es que no es la primera vez que Google tiene que lidiar con la crítica por sus algoritmos inexactos —ya lo hizo después de que su aplicación de fotos etiquetara la foto de una pareja negra como "gorilas"—, ni tampoco es la primera compañía con servicios de generación de IA en hacerlo.

La empresa rival OpenAI también fue acusada de perpetuar estereotipos nocivos, después de que los usuarios descubrieran que su generador de imágenes Dall-E respondía a las búsquedas de director ejecutivo con resultados donde predominantemente aparecían hombres blancos.

'Woke' contra Google

"Es vergonzantemente difícil conseguir que Google Gemini reconozca que existen personas blancas", escribió el informático Debarghya Das en X.

"Venga ya", dijo el escritor y humorista Frank J. Fleming, colaborador del medio de comunicación PJ Media, que ha sido tildado en algunas ocasiones de 'woke', en respuesta a los resultados que recibió en respuesta a los resultados que le dio la plataforma Gemini al pedirle una imagen de un vikingo.

Come on. pic.twitter.com/Zx6tfXwXuo

— Frank J. Fleming (@IMAO_) February 21, 2024

Algunos usuarios, como Fleming, arremetieron contra el jefe de Gemini, Jack Krawczyk. Una embestida a la que también se sumó, con un comentario burlón, el mismísimo Elon Musk.

What a racist douchenozzle!

— Elon Musk (@elonmusk) February 22, 2024

¿El algoritmo discrimina?

"La IA reproduce el racismo estructural", señaló la experta en IA y coordinadora de Algorace, Paula Guerra, en declaraciones recogidas por Europa Press, durante el X Congreso de Derechos Humanos de la Abogacía, celebrado el pasado mes de diciembre. La organización de la que forma parte publicó recientemente un informe donde se profundiza en la discriminación algorítmica que reproduce patrones racistas.

De acuerdo con Guerra, los algoritmos tienen dificultad para identificar rostros de personas no blancas, e incluso los utilizados por la policía para comprobar si una denuncia es falsa también cuenta con un marcado sesgo racial.

Una investigación del Washington Post, publicada en 2023, mostró múltiples ejemplos de generadores de imágenes que mostraban prejuicios contra las personas de color, así como sexismo. Se analizaron las imágenes generadas por Stable Diffusion XL y se constató que mostraba a las personas que recibían cupones y cheques de alimentos como no blancas o de piel oscura.

Al contrastarlo con la realidad, en la que el 63% de los receptores de cupones de alimentos en EEUU son blancos, se descubrió un sesgo racial. Lo mismo sucedió al buscar "persona en los servicios sociales".

En declaraciones a The Guardian, Andrew Rogoyski, del Instituto de Inteligencia Artificial Centrada en las Personas de la Universidad de Surrey, afirmó que "en la mayoría de los campos del aprendizaje profundo y la inteligencia artificial generativa es difícil mitigar los sesgos", por lo que es probable que se produzcan errores.

"Hay mucha investigación y muchos enfoques diferentes para eliminar el sesgo, desde la curaduría de conjuntos de datos de entrenamiento hasta la introducción de guardarraíles para modelos entrenados", dijo. "Es probable que las IA y los LLM [grandes modelos lingüísticos] sigan cometiendo errores, pero también es probable que esto mejore con el tiempo".