Lo último en ciberestafas pasa por el uso de las tecnologías de inteligencia más avanzadas para coaccionar a los objetivos para obtener dinero o datos personales. El 5 de marzo, The Washington Post se hacía eco de la historia de una mujer de 73 años, Ruth Card (73 años), que recibió una llamada supuestamente de su nieto Brandon que le decía que estaba en la cárcel sin teléfono ni tarjeta. En dicho caso, no era su nieto el que le había llamado: se trataba de una voz generada por inteligencia artificial (IA), un deepfake.

"Necesito dinero para la fianza". Eso fue lo que escuchó la septuagenaria y aseguraba que la voz sonaba exactamente igual que la de su familiar. Card se dirigió de inmediato al banco a retirar 3.000 dólares con la intención de depositarlos en otra cuenta. Pero, en este caso, el director del banco le paró los pies y logró alertarle de que se trataba de una estafa.

El término deepfake, también referido como medio sintético o vídeo ultrafalso, es una acronimia del concepto aprendizaje profundo (o deep learning), una de las formas más empleadas de la IA, y fake, que significa falso en inglés. En una publicación de 2020 de la Oficina de Seguridad del Internauta, se definen como "vídeos manipulados para hacer creer a los usuarios que los ven que una determinada persona, tanto si es anónima como si es personaje público, realiza declaraciones o acciones que nunca ocurrieron".

[Esto debes hacer para que el banco te devuelva el dinero perdido en una ciberestafa]

La cantidad de este tipo de contenidos altamente sofisticados en la red se ha multiplicado. Un ensayo del profesor Zahid Akhtar de la Universidad Politécnica de Nueva York publicado en enero de este año advirtió que "se espera que los deepfakes lleven la desinformación y las fuentes de malinformación actuales al siguiente nivel".

Esto, según Akhtar, "podría ser aprovechado por trolls, bots, teóricos de la conspiración, medios de comunicación hiperpartidistas y gobiernos extranjeros; así, los deepfakes podrían ser las noticias falsas 2.0".

El mismo estudio señala que esta peligrosa tecnología se está empleando con distintas finalidades. Por un lado, se está dando cabida a contenidos alterados para revivir a personajes históricos para utilizarlos en la educación. Y por otro, se están explotando deepfakes para fines menos amables, como la difusión de pornografía falsa para la manipulación o extorsión, manipular elecciones, generar polémica con declaraciones falsas, o para suplantar la identidad.

¿Cómo se generan?

Los medios sintéticos se fabrican gracias a la invención de las redes generativas antagónicas (RGA, por sus siglas en inglés), basadas en las denominadas redes neuronales.

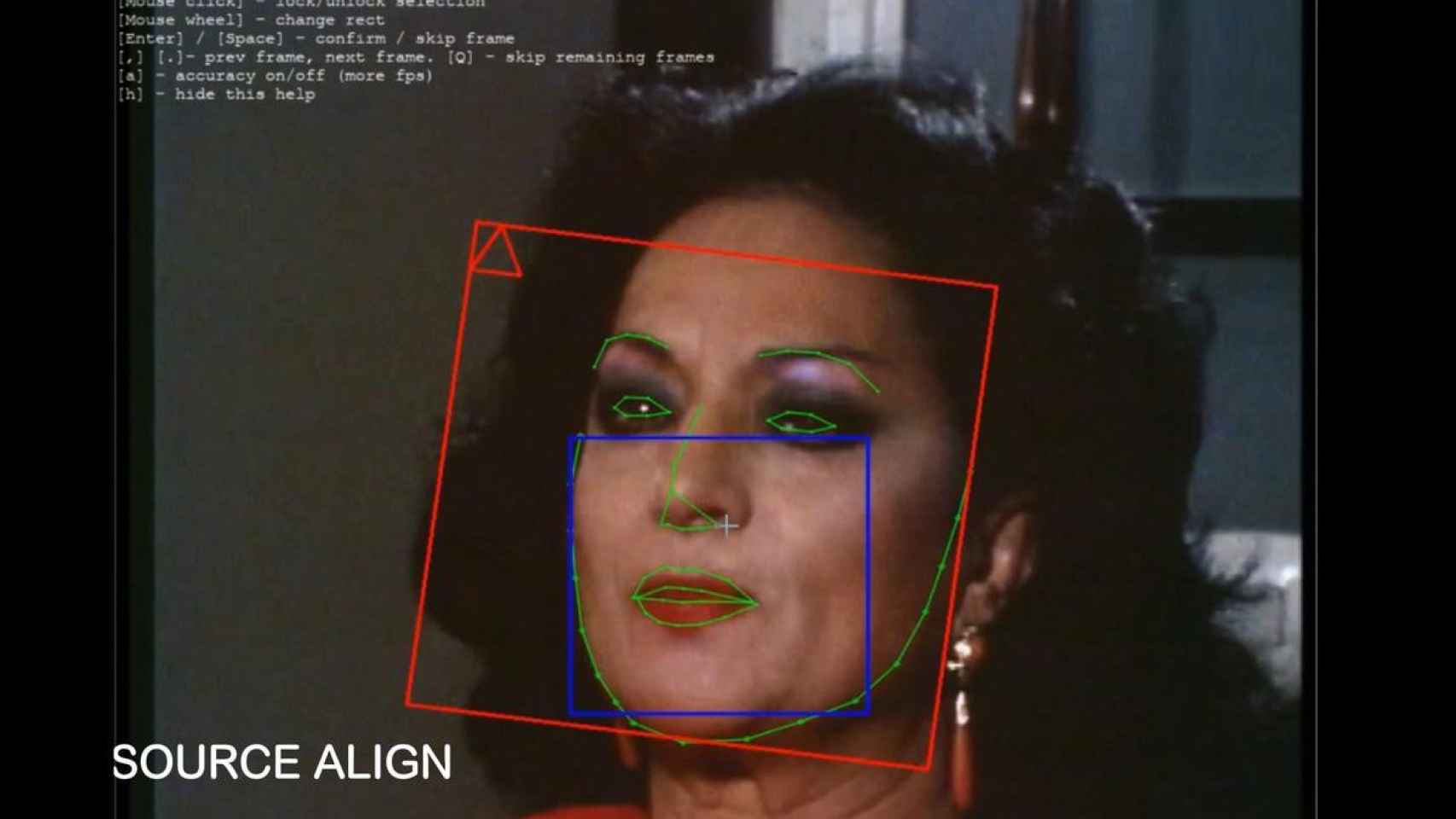

Como explican Markus Appel y Fabian Prietzel en The detection of political deepfakes, publicado el año pasado en el Journal of Computer-Mediated Communication, esta forma de aprendizaje profundo no supervisado consta de dos programas o algoritmos de IA: uno que falsifica una imagen y otro —el discriminador— que detecta la falsificación. Este circuito se retroalimenta, adaptándose y mejorando el resultado.

Esta es la lógica detrás de los deepfakes de discursos de distinguidas personalidades de la política mundial. Para mimetizar la cara, incluyendo las expresiones faciales de una persona, se parte de un volumen muy grande de datos sin procesar. Se proporciona información sobre dos categorías: por un lado, los rasgos faciales, y por otro, la orientación de la cabeza y las expresiones.

Se inyecta una gran cantidad de imágenes de una persona en varios ángulos. El programa detecta los rasgos principales para aprender sus rasgos faciales. Y entonces se genera el vídeo en cuestión a partir de las imágenes proporcionadas.

Pornografía y 'deepfakes'

Si bien también se utiliza la tecnología de los deepfakes para elaborar contenido benignos, como aquel popular anuncio de Cruzcampo en el que se mostraba una imagen sintética de Lola Flores o las aplicaciones de móvil que nos envejecen o cambian la apariencia de nuestro rostro, la mayoría no son tan inofensivos.

Ya en 2019, un estudio de Deeptrace Labs descubrió que el 96% de los vídeos deepfakes en línea son pornográficos. Y gran parte se clasifica como pornografía involuntaria (o revenge porn). A principios de este mismo mes se informó de la circulación masiva en redes sociales como Meta o Facebook de vídeos en los que aparecen famosos presuntamente a punto de realizar una felación. Entre estos rostros estaba el de la actriz Emma Watson.

[Miles de deepfakes sexuales de Emma Watson aparecen en Facebook e Instagram]

En la investigación de estos hechos, realizada por Kat Tenbarge para NBC News, se revelaba que el domingo 5 y el lunes 6 de marzo una aplicación para crear intercambios de cara deepfake lanzó una campaña publicitaria con más de 230 anuncios distribuidos en las redes sociales de la empresa Meta. Se pudieron ver en Facebook, Instagram y Messenger.

También se han generado vídeos de personas influyentes como Barack Obama, Vladímir Putin o Volodímir Zelenski. Un ejemplo muy sonado que llamó mucho la atención por la actualidad de los hechos acaecidos en Ucrania fue el que mostraba al presidente ucraniano presuntamente ordenando a sus soldados a que se rindieran ante las fuerzas rusas. Al poco tiempo, se desenmascaró este contenido sintético.

¿Cómo detectarlos?

A principios del año pasado, un estudio de Sophie J. Nightingale y Hany Farid, publicado en la revista Proceedings of the National Academy of Sciences, demostró que los humanos son incapaces de distinguir los rostros generados artificialmente de los reales y, además, los falsos les generan un mayor nivel de confianza que los verdaderos. Por eso, es importante advertir de aquellos elementos que permiten discernir entre un deepfake y un video inalterado.

[Los 'deep fakes' son cada vez más realistas: expertos piden regularlos cuanto antes]

De acuerdo con Appel y Prietzel, hay tres componentes en los que hay que fijarse. En primer lugar, el contexto es clave: se debe mirar siempre cuándo se ha publicado el video y en qué circunstancia. Igual de importante son las imperfecciones audiovisuales (o fallos tecnológicos). A menudo se pueden detectar anomalías o errores en la imagen o en el audio de un vídeo. Es así como podemos empezar a sospechar de que podría tratarse de un deepfake.

Pero el elemento más importante para detectarlos es el propio contenido del vídeo. Si lo que se dice o muestra en el vídeo parece inverosímil, hay que desconfiar y, siempre que sea de interés, comprobar su veracidad.

Otros contenidos engañosos, con el mismo objetivo que los medios sintéticos, son los llamados shallowfakes. A diferencia de los primeros, los shallowfakes no emplean técnicas avanzadas de aprendizaje profundo. Simplemente se utiliza un software de edición de video para alterar el contenido existente.