Pantalla del iPhone 16 Pro Max Omicrono

Apple analizará emails para entrenar su IA: así trata de alcanzar a ChatGPT sin renunciar a la privacidad

El gigante explica un nuevo método de entrenamiento usando datos de sus dispositivos, con el permiso de los usuarios y manteniendo la privacidad.

Más información: Los problemas de Apple con la nueva Siri: su versión con IA "más conversacional" podría retrasarse al menos hasta 2027

Los datos que generan todos los usuarios de internet desde teléfonos y ordenadores se han convertido en el oro con el que entrenar a la inteligencia artificial del mañana. Industria y gobiernos debaten por el equilibrio entre preservar la privacidad de las personas y nutrir a los modelos de lenguaje natural que han dado chatbots como ChatGPT y Gemini entre otros. Apple es uno de los gigantes tecnológicos que lucha desde hace dos años por alcanzar a sus rivales y mantener la promesa de privacidad que hace cada año a sus clientes.

La IA necesita grandes conjuntos de datos para aprender a comunicarse y generar contenido como los humanos. Meta, empresa de Mark Zuckerberg ha anunciado esta semana que comenzará a entrenar su IA con contenido público de los usuarios en la UE. Por su parte, Apple ha detallado cómo funciona su nuevo sistema de entrenamiento en el que usa correos electrónicos de ciertos usuarios.

La empresa promete proteger la privacidad de sus clientes, al mismo tiempo que se nutre de estos para mejorar la capacidad de sus modelos de lenguaje natural. El fabricante de iPhones acaba de pasar por una crisis por el retraso de su prometido nuevo asistente virtual, Siri, vitaminado con IA generativa. Con esta nueva metodología pretende mejorar la función que resume los correos o ayuda a escribirlos.

Apple Intelligence

Por ahora, se habría limitado a usar datos sintéticos, es decir, información que imita las entradas del mundo real, pero sin incluir datos personales. No obstante, esta clase de contenido no es suficiente para desarrollar modelos de lenguaje natural capaces de competir con los líderes actuales de la industria. El fabricante ha tomado la decisión de analizar datos de los dispositivos de sus clientes para mejorar su trabajo en IA.

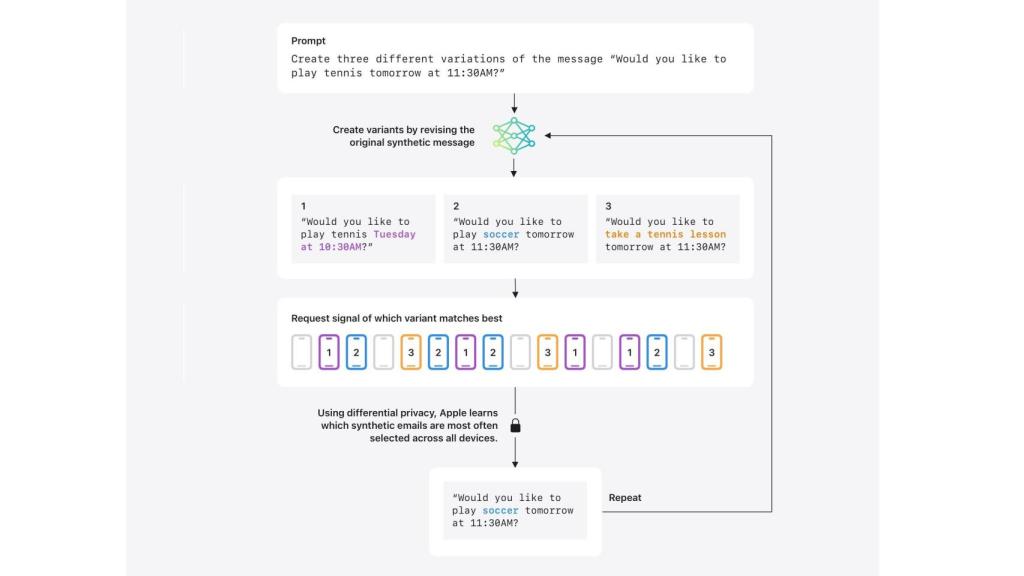

Cómo utilizar contenido real sin poner en riesgo las conversaciones privadas de las personas es la clave. Apple asegura seguir salvaguardando la privacidad de sus usuarios con este nuevo método de entrenamiento y revisión que funciona así: se comparan los datos sintéticos creados por Apple con una muestra reciente de correos electrónicos de usuarios dentro de la aplicación de email de iPhone, iPad y Mac.

Esquema de Apple y su sistema de Privacidad Diferencial Omicrono

Esta comparativa facilita a la tecnología determinar qué conjunto de datos sintéticos se ajusta más a la realidad, a los mensajes que las personas de carne y hueso se mandan. No obstante, el contenido de los correos electrónicos reales comparados con los datos sintéticos nunca sale del dispositivo ni se comparte con Apple.

Esta novedad se desplegará en una próxima versión beta de iOS, iPadOS 18.5 y macOS 15.5, y solo implicará aquellos dispositivos cuyos dueños se hayan suscrito al programa Análisis de Dispositivos, es decir, que permitan el uso de su terminal para mejorar los resúmenes de los correos electrónicos.

Esta opción se activa en la pestaña de Privacidad y Seguridad dentro de la Configuración del terminal. Una vez inscrito, el dispositivo participante solo envía una señal que indica cuál de las variantes de datos sintéticos generadas se asemeja más a los datos muestreados en los correos. De esta forma, Apple aprende qué correos electrónicos sintéticos se han seleccionado con más frecuencia en todos los dispositivos que participan en este programa, no la selección individual de cada dispositivo.

Utiliza este sistema para "identificar indicaciones y patrones populares, a la vez que ofrece una garantía matemática de que no se descubran indicaciones únicas o poco comunes", según explicó la compañía en la entrada del blog. En teoría el modelo mejora en aquellas solicitudes similares entre varios usuarios y no en los casos personales.

Este sistema se ha llamado Privacidad Diferencial y ya se ha utilizado algo similar en la función Genmoji, que permite a los usuarios crear un emoji personalizado. Se identifican indicaciones y patrones populares, "a la vez que ofrece una garantía matemática de que no se descubran indicaciones únicas o poco comunes", ha explicado la compañía en su blog. "Aplicamos filtros para eliminar información personal identificable, como los números de la seguridad social y de tarjetas de crédito", aseguran.