El auge de la inteligencia artificial ha convertido a Nvidia en la tercera empresa tecnológica más valiosa del mundo, por detrás de Microsoft y Apple. Esta tecnología no solo es software, depende en gran medida del hardware para ejecutar enormes cargas de trabajo informático. Por ello, los grandes desarrolladores de IA están invirtiendo en la creación de sus propios chips, con el objetivo de disminuir su dependencia de los poderosos semiconductores de empresas como Nvidia.

Meta (matriz de Facebook, Instagram y WhatsApp) ha anunciado esta semana su segunda generación de procesadores, que inició el año pasado, y que sirven a los modelos de IA que clasifican y recomiendan anuncios en las plataformas de la empresa. El nuevo MTIA (Meta Training and Interference Accelerator) ofrece un rendimiento general hasta 3 veces mayor que su predecesor, según explica Meta.

Este anuncio llega justo después de las diversas iniciativas de la compañía en materia de inteligencia artificial y de haber advertido que están trabajando para "conseguir que estos modelos no solo hablen, sino que razonen, planifiquen... que tengan memoria". Se espera que lancen en breve Llama 3 un modelo de lenguaje natural que compite con grandes como Google u OpenAI en una carrera acelerada.

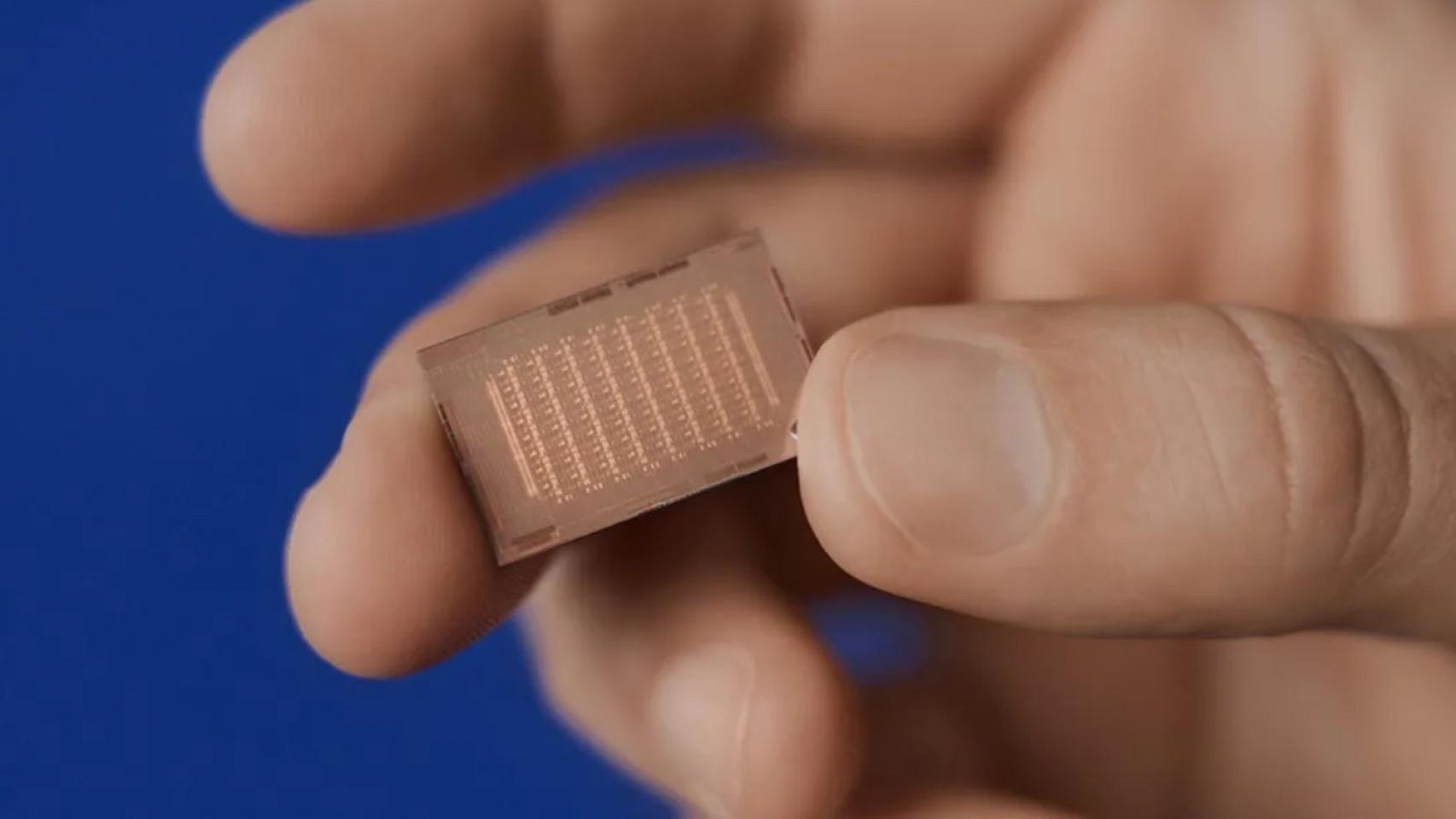

Chip MTIA de Meta

"La arquitectura de este chip se centra fundamentalmente en proporcionar el equilibrio adecuado entre computación, ancho de banda de memoria y capacidad de memoria para servir modelos de clasificación y recomendación", indica la compañía en su blog. En comparación con su primer chip, el MTIA v1, creado en un proceso de 7 nm, el nuevo MTIA de segunda generación es de 5 nm, se refiere al tamaño del componente más pequeño que se puede construir en el chip.

Además, este semiconductor tiene un diseño físicamente más grande, equipado con más núcleos de procesamiento que su predecesor. La empresa afirma que el MTIA consume más energía (90 W frente a 25 W), aunque cuenta con más memoria interna (128 MB frente a 64 MB) y funciona a una velocidad de reloj promedio más alta (1,35 GHz frente a 800 MHz).

CEO de Meta, Mark Zuckerberg

Esta novedad está actualmente disponible en 16 regiones de sus centros de datos, aunque, todavía no supone una independencia alta del resto del mercado. A principios de este año, Zuckerberg dijo que la compañía adquiriría 350.000 de los chips H100 de Nvidia, que cuestan decenas de miles de dólares cada uno.

En el comunicado reconoce que el MTIA no se está utilizando aún para entrenar a su IA generativa; están trabajando en ello. Tampoco tienen intención de reemplazar a las GPU para ejecutar y entrenar modelos con este nuevo chip, sino que llega para complementarlas.