Apple suele tener una especial fijación por las opciones de accesibilidad en España. La compañía de Cupertino ha aprovechado la puesta a la venta de sus nuevos iPad Pro M4 e iPad Air M2 para dar a conocer numerosas funciones de accesibilidad. De la plétora de características anunciadas, la más interesante es la de Eye Tracking, una novedad que llega a iPad e iPhone para que los usuarios puedan controlar sus dispositivos con los ojos.

Si bien ya era posible controlar dispositivos de Apple como los iPad mediante dispositivos de seguimiento ocular, esta no era una opción que pudiera usarse de forma nativa en el iPhone o iPad. Dado lo solicitada que ha sido esta característica, Apple ha decidido incorporarla para permitir a los usuarios usar sus productos mediante la cámara frontal del dispositivo.

Por supuesto esta es una novedad que está totalmente impulsada por el poder de la inteligencia artificial, siendo esta otra demostración más del vuelco que ha dado Apple a la carrera por la IA. Lo más llamativo de esta novedad de Eye Tracking es que no requiere de hardware adicional de ningún tipo.

Controla tu iPhone con los ojos

Eye Tracking, como indica su nombre, es una opción integrada dentro de las opciones de accesibilidad de iPadOS e iOS, los sistemas operativos de iPad e iPhone respectivamente. Se vale de la cámara frontal de estos dispositivos para detectar mediante IA la mirada del usuario, y que así este pueda navegar por el sistema.

Esta es una función pensada específicamente para usuarios que cuenten con discapacidades físicas y que tengan problemas a la hora de poder controlar sus dispositivos de forma convencional. Eye Tracking configura el sistema y lo calibra en apenas segundos, todo ello de forma local y directamente en el dispositivo, gracias a las capacidades de aprendizaje automático de las tabletas y móviles de Apple.

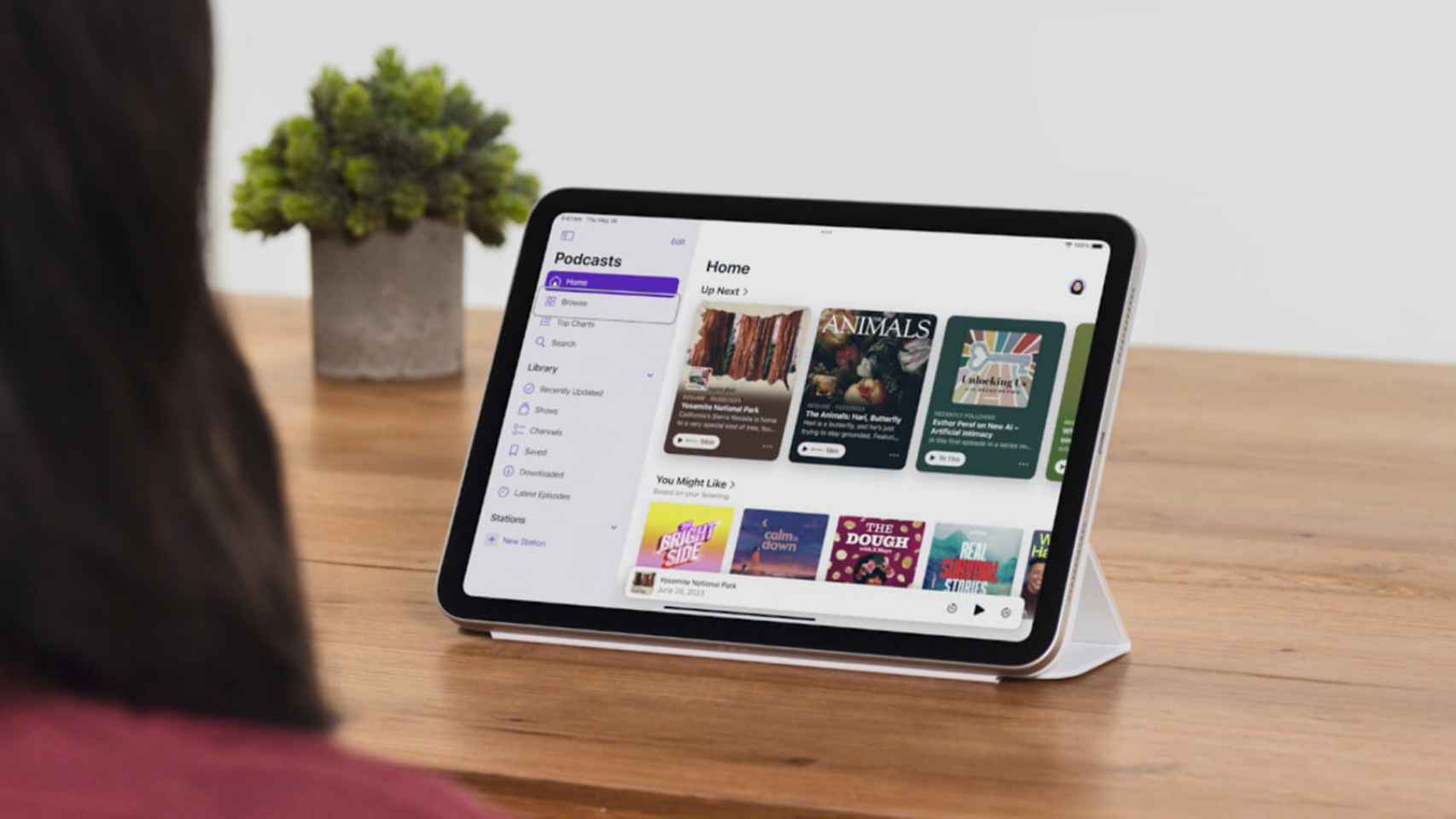

Persona usando Eye Tracking.

La privacidad sigue siendo la gran baza de este sistema, ya que todos los datos que Eye Tracking usa para configurar y controlar esta función se quedan en el dispositivo; no se comparten con nadie y no salen de lo local. De hecho, ni siquiera se comparte con Apple, siendo una característica increíblemente segura para con el usuario.

El sistema de uso es tremendamente sencillo. Eye Tracking se encarga de que el usuario pueda navegar por los elementos de una aplicación, y Dwell Control permite activarlos. Solo con los ojos, el dueño del iPad o iPhone puede desde deslizar hasta pulsar botones físicos, pasando por realizar gestos. De nuevo, insistimos: Eye Control no precisa de hardware dedicado de ningún tipo.

iPad usando eye tracking

Junto a Eye Tracking, Apple ha presentado un conjunto bastante importante de funciones de accesibilidad. Un ejemplo es Music Haptics, ideada para personas con problemas de audición o que sufran de sordera. Aprovechando el Taptic Engine del iPad o iPhone, el dispositivo reproduce "texturas y vibraciones refinadas al audio de la música". Estará disponible en forma de API para que los desarrolladores puedan hacer más accesible los temas que se reproduzcan.