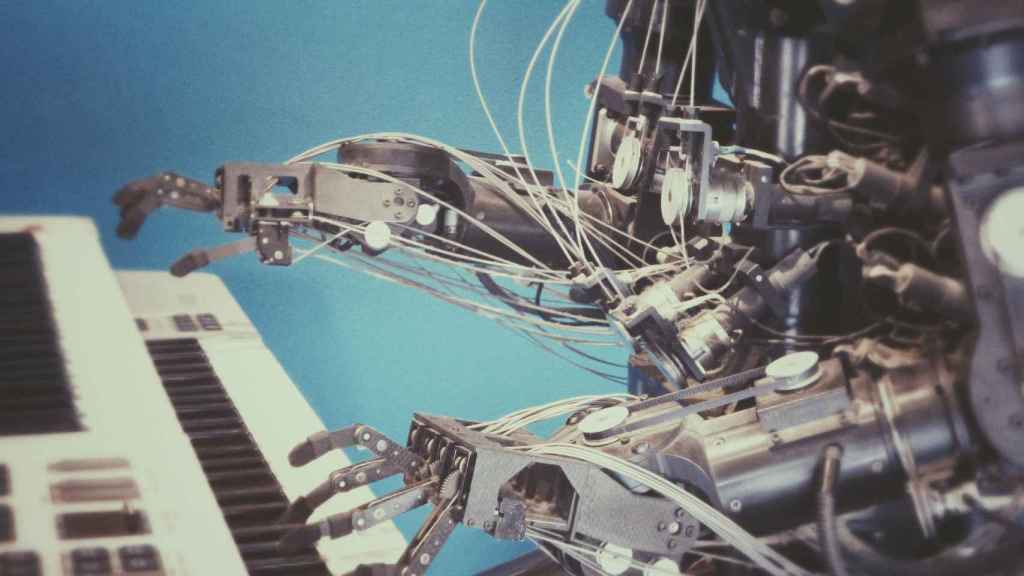

La IA está presente en cada vez más campos de nuestras vidas.

2021: el año en que aprenderemos a crear una inteligencia artificial ética

La asociación OdiseIA está reuniendo a un grupo de expertos de los sectores público y privado en España para preparar un manual de mejores prácticas.

8 diciembre, 2020 00:09Noticias relacionadas

El desarrollo de tecnologías de inteligencia artificial tiene evidentes implicaciones jurídicas, socio-económicas y éticas. Lo hemos escuchado infinidad de veces. ¿A qué nos referimos exactamente al hablar de ética en los algoritmos? Un ejemplo socorrido es el siguiente: si un coche autónomo tuviera que escoger entre atropellar a un niño o a un anciano, ¿qué decisión debería tomar?

Parece un ejemplo, sencillo, ¿verdad? Lo lamentamos, pero rara vez la realidad es así de simple. Apliquemos el llamado 'Dilema del Tranvía': imagina que ves un tren sin frenos acercándose peligrosamente a un grupo de cinco personas. Tienes a tu lado una palanca para desviarlo y que tome otra vía, en la que es seguro que atropellaría mortalmente a una sola persona. La mayoría de las personas accionaría la palanca. Pero, ¿y si el único modo de evitar la tragedia fuera que empujaras a un hombre desde un puente, que éste cayera sobre la vía y frenar así al tren? Las decisiones que implican vidas humanas nunca son fáciles de tomar.

Un ejemplo más divertido lo encontramos en el libro ‘Lo imprevisible’, de Marta García Aller: imagina que le pides a tu robot que prepare una cena rica en proteínas y cuando llegas a casa ha metido al gato en el horno. Las máquinas carecen de nuestro esquema de valores. No distinguen entre el bien y el mal, y a menudo desconocen todo el contexto. Este es el motivo por el que algunos investigadores dudan que sea posible desarrollar una gran inteligencia artificial (IA) de carácter general.

Sí que son posibles, y de hecho ya conviven entre nosotros, muchos tipos de inteligencias artificiales especializadas. “La IA se usa cuando compramos por Internet, cuando nos recomiendan películas o canciones, cuando traducimos automáticamente un texto, o cuando hablamos con nuestros dispositivos. Pero también hace predicciones o participa de decisiones que tienen un impacto más importante en nuestras vidas, como cuando queremos contratar un producto financiero o un seguro. En un futuro cercano, incluso la tendremos cuando nos hagan un diagnóstico médico o participemos en un proceso judicial, y un largo etcétera que irá aumentando a medida que se incremente la apuesta por esta tecnología en las empresas y organismos españoles”, explican desde OdiseIA. Esta asociación independiente y sin ánimo de lucro nació en 2019 de la mano de un grupo de empresas, universidades, instituciones y expertos preocupados por fomentar el impacto social positivo de estas tecnologías.

Y entre estas aplicaciones de la IA en nuestro día a día, encontramos fallos que tienen peligrosos efectos sobre nuestra sociedad y nuestra economía. Fallos, en su mayoría, que los algoritmos han “aprendido” de los imperfectos seres humanos que los programaron. Entre otros, “la perpetuación de estereotipos o malas prácticas sociales, como la discriminación de minorías, razas o géneros”, señalan en OdiseIA. Pero también la opacidad de algunos de algoritmos, o la excesiva autonomía que brindamos a estos sistemas.

“Por estos motivos es tan necesario el desarrollo, paralelo a la evolución de la técnica, de la ética asociada a estas aplicaciones”. La propuesta que brinda OdiseIA se llamará GuIA y consistirá en un manual de buenas prácticas, con medidas reales y concretas. Para ello, tienen previsto aglutinar a los principales actores que conforman el ecosistema de la IA en nuestro país. “Un necesario ejercicio de colaboración público-privada que dinamice la asimilación de la IA de una manera ética en todos los sectores empresariales”, apuntan.

Calendario de trabajo

Una vez conformado el grupo de trabajo, y tras un análisis exhaustivo de cada una de las estrategias presentadas, está previsto que publiquen sus conclusiones a lo largo del primer trimestre de 2021. A continuación se abrirá un “periodo de análisis colaborativo entre expertos de distintas áreas -diferenciados por sectores-, los cuales aportarán su punto de vista y necesidades reales al documento”. Asimismo, se realizarán workshops específicos con representantes de dichas empresas y organismos. Por último, en octubre de 2021 está previsto que se celebre un evento para presentar los aprendizajes de GuIA.

El anuncio de esta nueva iniciativa coincide en el tiempo con la presentación de la Estrategia Nacional de Inteligencia Artificial (ENIA) del Gobierno, publicada la semana pasada. Precisamente, uno de sus seis ejes estratégicos es “Establecer un marco ético y normativo que refuerce la protección de los derechos individuales y colectivos, a efectos de garantizar la inclusión y el bienestar social”. Sobre la cuestión de la ética de los algoritmos, la ENIA dice: “La reflexión ética vive en un estado previo y paralelo a la regulación (...) La sociedad democrática debe tomar conciencia de que su control debe alcanzar –también- al diseño de la ingeniería, promoviendo que, a la vez que se desarrollan productos comerciales, se apuesten por tecnologías orientadas a mejorar servicios públicos con beneficios colectivos y sociales”.

Asimismo, hasta el próximo 20 de diciembre está abierta la consulta pública de la Carta de Derechos Digitales, “con el fin de identificar un conjunto de principios fundamentales que puedan inspirar la producción normativa -tanto a nivel nacional como comunitario- para adaptarla a las nuevas situaciones y circunstancias del ámbito digital y, en particular, las relativas a la extensión de la IA”. No en vano, la Secretaría de Estado de Digitalización e IA, valedora tanto de la ENIA como de la Carta de Derechos Digitales, participó hace unos días en el evento de presentación de GuIA.

“En un mundo en el que los prejuicios de ciencia ficción, asociados a estas tecnologías, hacen soñar con robots que sustituyen y superan a la humanidad, son necesarias iniciativas que aterricen los conceptos y utilidades reales de la IA para cada sector, y que aseguren su uso responsable con el fin de prevenir estas consecuencias negativas”, concluyen en la asociación OdiseIA.