Uno de los impactos más grandes de la automatización por software, es el de la que se ha dado en llamar IA generativa, que está impactando de lleno en la maquinaria de producción de los mass media y el trabajo periodístico. O sea, en lo que en EE.UU. llaman 'la maquinaria de producción de las noticias', en la que el lenguaje es su núcleo central. Por eso, es lógico que esta tecnología se aplicara pioneramente en ese ámbito, y con intensidad, desde hace varios años.

Lo que está ocurriendo con la introducción de la IA generativa (en realidad machine learning predictivo) en algunas redacciones plantea dilemas inquietantes. Por ejemplo, ¿aplicar la IA generativa al ámbito de las redacciones periodísticas lubricará su maquinaria y aumentará su productividad, y/o la oxidará como actividad humana? ¿Convertirá su aplicación a escala industrial en innecesaria la labor de muchos de los periodistas en las redacciones de medios? ¿Va a ser automatizado el trabajo de los periodistas a gran escala? Son grandes preguntas que afectan al papel del periodismo en sus audiencias, y por extensión, en las sociedades democráticas.

El impacto de la IA generativa en la función periodística se había silenciado desde el principio, ya que a muchos editores y empresarios de medios no les convenía hablar de impacto de la inteligencia artificial en las 'tripas' de su sistema editorial, pero un incidente casi fortuito lo ha sacado a la luz.

Parece algo nuevo, pero no lo es. Hay antecedentes. Un diario tan conocido como The Guardian, publicó por primera vez en la historia, oficialmente, un artículo editorial de opinion (op-ed) firmado por una máquina, o sea por el software GPT-3. Fue el día 8 de septiembre de 2020 y lo tituló: 'Un robot escribió todo este artículo. ¿Ya tienes miedo, humano?'. Dos años después, ha publicado un artículo que comenzaba con el título: 'El bot de IA ChatGPT asombra a los académicos con sus habilidades de redacción y su usabilidad'.

Vaya por delante que la apariencia del texto generado por GPT-3 es tal que puede resultar difícil determinar si ha sido escrito o no por un humano, lo que tiene tanto ventajas como riesgos. 31 investigadores e ingenieros de OpenAI presentaron el 28 de mayo de 2020, en el paper original de presentación de GPT-3, un documento en el que advertían seriamente sobre los peligros potenciales de GPT-3 y hacían un llamamiento a la investigación para mitigar los riesgos. En abril de 2022, The New York Times describió las capacidades de GPT-3 como un artefacto capaz de escribir prosa original "con una fluidez equivalente a la de un humano".

Pero según un científico especializado, este software no es puramente inteligencia artificial sino simplemente una "proeza estadística" ya que ha sido entrenado como sus predecesores, no posee comprensión alguna sobre sentido ni significado de las palabras que emite. Se limita a predecir estadísticamente la siguiente palabra más probable que va en cada frase, basándose en sus datos de entrenamiento, que, además, pueden ser incorrectos.

Pero hace pocas semanas todo se ha acelerado alrededor de la IA generativa. En ese contexto, un usuario de Twitter ha mostrado que el uso de IA generativa se estaba generalizando en los medios de manera muy discreta. Y una investigación posterior reveló que muchos artículos publicados se han 'generado' (no sé si se puede llamar a esto 'redactado'), usando ChatGPT, o GPT-3, desde noviembre de 2022. Así se ha descubierto que el prestigioso medio digital de noticias tecnológicas CNET estaba usando inteligencia artificial generativa para 'escribir' y publicar artículos sobre finanzas personales, usándola sin previo aviso ni explicación a los lectores.

Los artículos detectados (73 en total) trataban temas como '¿Qué es Zelle y cómo funciona?' (Zelle es la red de pagos digitales de EE.UU. propiedad de Early Warning Services, a su vez propiedad de bancos como Bank of America, Truist, Capital One, JPMorgan Chase, PNC Bank, U.S. Bank y Wells Fargo). Dichos artículos solo tenían un pequeño 'descargo de responsabilidad' al final en el que se leía: "Este artículo se ha generado utilizando tecnología de automatización y ha sido editado y comprobado por un redactor [humano, se entiende] de nuestro equipo editorial". La autoría de estos artículos era de "CNET Money Staff" sin ninguna indicación de que habían sido creados por una IA generativa.

Obviamente, la información ha generado un revuelo considerable. Y ante ello, el redactor jefe de CNET tuvo que salir a la palestra para defender por qué esos artículos fueron 'escritos' por una IA generativa antes de publicarlos. Para quitar hierro al asunto, CNET usó una expresión eufemística: "Ayuda de la IA", afirmando que, "si bien el motor de IA compiló el borrador de la historia o recopiló parte de la información para la narración, cada artículo de CNET -y publicamos miles de historias nuevas y actualizadas cada mes–, es revisado, verificado y editado por un editor [humano, se supone] con experiencia en el tema antes de que lo publiqluemos. Esa seguirá siendo nuestra política, independientemente de las herramientas o tecnologías que utilicemos para crear esos artículos."

A pesar de que los citados 73 artículos se habían publicado como hechos por un periodista (humano), sin avisar al lector de ello, culminó la defensa de la actuación de su medio CNET, declarando: "Nuestra reputación, 'basada en hechos comprobados' como fuente objetiva e imparcial de noticias se basa en la transparencia de nuestra forma de trabajar y de las fuentes en las que nos basamos." Y concluye: "¿Haremos más cambios y probaremos cosas nuevas mientras seguimos aprendiendo y comprendiendo las ventajas y retos de la IA? La respuesta es sí."

Ya está comprobado, y además reconocido por los creadores de Open AI, que las IA generativas como ChatGPT no comprenden la diferencia entre verdadero y falso, ni el significado de términos o palabras. ¿Cómo entonces el lector se podrá fiar que lo que dice un artículo publicado, –reconocido por CNET que ha sido redactado por una IA generativa–, si la máquina que lo ha escrito no distingue entre verdadero y falso? ¿Puede un software así comprobar hechos si no distingue si algo sucedió o no? Lógicamente, no puede. La frase 'basada en hechos comprobados' hace que sea papel mojado al respecto una historia escrita por una IA generativa.

¿Pueden apoderarse la 'IA generativa' de la maquinaria periodística?

A pesar de ello, el uso de estas tecnologías en los medios de comunicación o mass media –por usarla terminología de McLuhan y no incluyo en ellos a las redes sociales–, casi parece inevitable e irreversible. Las noticias también son un negocio. Después del citado suceso de CNET, ha salido también a la luz que muchos medios importantes ya estaban comportándose igual y usando profusamente la IA generativa en diversas facetas como una "simple ayuda tecnológica más".

Por ejemplo, The Associated Press (AP), que fue una de las primeras en aprovecharla para la creación de contenidos. Lleva utilizándola desde 2014 para generar resúmenes de los informes de resultados de las empresas que cotizan en bolsa. Esto les permite –afirma su editor–, "proporcionar a los lectores información clave de forma rápida y precisa, 'liberando' a los reporteros para realizar otras tareas"–señalan en su página web–, y añaden que esto "distraía del periodismo de mayor impacto". Donde ponen 'liberando' también cabría el término 'sustituyendo'.

Pero esta tecnología ya se está probando en los medios para más cosas e incluso está midiendo la rentabilidad del uso de las máquinas de software en sustitución del trabajo de periodistas humanos. Por ejemplo, en la relación de los medios y las redes sociales. El South China Morning Post ha declarado que ahorra recursos humanos equivalentes al trabajo realizado por 3,9 empleados (periodistas especializados) a tiempo completo, al utilizar la IA generativa para agilizar la gestión de sus redes sociales.

Según Digital Content Next la IA generativa está cambiando el funcionamiento de las redacciones y la edición de los medios y pone algunos ejemplos. Ya se usa en el análisis de audiencias, publicidad programática o creación automatizada de historias. También imitando a las grandes plataformas globales que usan tecnología de recomendación personalizada –pilar de Amazon, Spotify o Netflix–, se ha empezado a usar en la prensa escrita el machine learning y sus algoritmos para personalizar las recomendaciones de contenido.

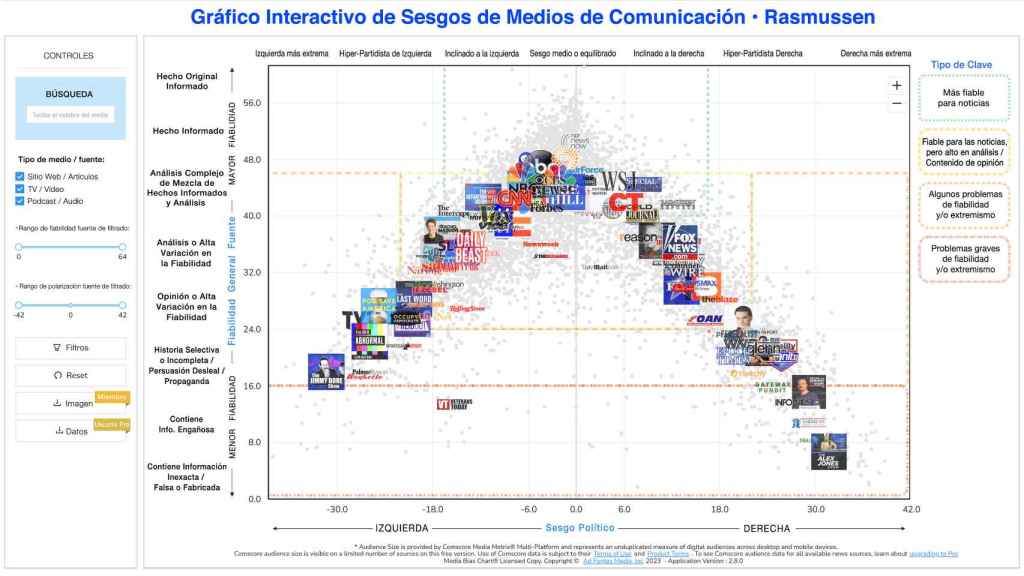

Gráfico de Sesgo Mediático de una aplicación interactiva algorítmica de Comscore, que muestra un posicionamiento de medios basado en datos con el que adaptar al usuario las noticias (y la publicidad) desde el punto de vista que le resulte más satisfactorio mediante filtros algorítmicos. Tiene niveles de 'miembro' y de usuario profesional.

Periodismo algorítmico de gran pureza

The Washington Post, ahora propiedad del fundador de Amazon, Jeff Bezos, va más allá y utiliza la IA generativa para personalizar las noticias que ofrece en función de los intereses y preferencias de los lectores. Verbigracia: eso hará que cada lector del periódico lea una noticia diferente y perversamente adaptada a lo que estadísticamente a él le 'gustaría' leer, cosa que facilitan los datos que ha regalado a los mismos algoritmos que le bombean incesantemente información, la desee o no.

Este tremendo enfoque personalizado ya lleva algún tiempo siendo usando por el WPost en su app para móviles, en sus newsletters y, ahora, en la página de inicio. Probablemente es una evolución que puede conducir a periódicos con una trayectoria histórica muy prestigiosa hacia tener una conducta con la audiencia muy similar a la que tienen las redes sociales con sus usuarios, en busca del engagement (enganchamiento adictivo) radical en todos los sentidos.

Esta algorítmica se está usando para cosas que no hubiéramos imaginado antes. Por ejemplo, para lo que, otra vez eufemísticamente, se llama "dar forma a los contenidos que se leen y se ven", como es el caso del filtro de noticias positivas de Pink News. Su propósito es que le lleguen, personalizadamente, a cada determinado lector (ya convertido en usuario), solo las que con muy alta probabilidad el considera que son 'noticias positivas'. Bueno, las que el algoritmo generativo, que no distingue entre verdadero y falso, considere 'positivas' para ese lector en concreto. Es decir, darle al lector lo que a el más le gustaría oír, o leer (¿les suena?, en política se hace desde tiempo ha). No sea que una noticia desagradable amargue el día a ese lector.

Es una estrategia propia de las redes sociales aplicada a la prensa, que como ya sabemos, porque está demostrado, causan aceleración, polarización y neutralizan grandemente la capacidad de decisión del usuario. Por supuesto, las aplicaciones de la tecnología generativa no han hecho sino comenzar a llegar, y ya se están probando el sustituir a periodistas humanos, con la comprobación automatizada de hechos dentro de lo que se llama ya cobertura basada en 'datos', en lugar de basada en 'hechos'. Los datos con mucho más maleables que los hechos, como bien sabemos.

Los productivos robotperiodistas

Me pregunto ¿Vamos a empezar pronto a llamar a ciertos algoritmos 'periodistas no-humanos? Pues parece que sí. Por ejemplo, a la herramienta.algorítmica propia que ha creado la empresa del Washington Post llamada Heliograf, que lleva ya tiempo generando automáticamente actualizaciones breves de noticias del periódico de varias frases.

O la desarrollada por las empresas tecnológicas Automated Insights y Zacks Investment Research, que ha conseguido una productividad tal a Associated Press, que está generando automáticamente casi 4.000 artículos sobre los beneficios de las empresas estadounidenses cada trimestre, unas doce veces más de lo que creaban antes los periodistas y redactores (humanos) de AP.

La prestigiosa agencia internacional de noticias también crea en estos contextos (para nuestra tranquilidad) una pequeña fracción de estas 4.000 noticias, a las que los redactores (no algorítmicos, añaden "el toque humano" ofreciendo –dice— "interpretaciones" más matizadas.

El 'periodismo algorítmico' –a estas alturas ya le podemos llamarlo así sin titubeos– está en plena explosión y su expansión ya no se orienta solo a deportes y finanzas, aunque la audiencia de deportes es la que parece más 'asequible' para estas herramientas. Por eso, Associated Press ha añadido la información deportiva a sus actividades periodísticas automatizadas para las que sus editores y reporteros de béisbol configuraron la plataforma Wordsmith con la ayuda de la empresa tecnológica Automated Insights.

Uno de los 'robotperiodistas' más eficaces y populares en California es Quakebot, del que es autor el redactor de Los Angeles Times, Ken Scwenkie. Según Business Insider, Quakebot es un sistema automatizado que reside en los servidores de Los Angeles Times, que recibe correos electrónicos del servicio geológico de EE.UU., después pasa esos datos por una lista de comprobación de información y luego determina algorítmicamente, y autónomamente, si son de interés periodístico en función de la 'magnitud'. Vaya usted a saber qué entiende el algoritmo generativo por magnitud si no comprende ningún significado–.

A continuación, él mismo –si es que podemos hablar, también eufemísticamente, en tercera persona en este caso– analiza el contenido del correo electrónico y lo introduce en el sistema de gestión de contenidos de Los Angeles Times. Las 'entradas' o post publicadas se estructuran mediante una fórmula estadística basada en entradas anteriores. Es un planteamiento próximo al de toda la vida de muchos economistas: el presente se cuenta siempre en función de las estadísticas del pasado. No vendrá mucha innovación por ahí.

Periodismo 'aumentado' algorítmicamente

Como señala Andreas Graefe, autor del informe del Tow Center for Journalism, 'Guía del Periodismo Automatizado, el periodismo automatizado es especialmente útil para generar noticias 'rutinarias' –habituales, en muchos casos– sobre temas repetitivos para los que se dispone de datos limpios, precisos y estructurados. También destaca el potencial de los algoritmos para generar grandes volúmenes de noticias con rapidez, potencialmente orientadas desde múltiples ángulos predeterminados y personalizadas según las preferencias del lector.

Según el informe, la automatización en periodismo también tiene limitaciones y efectos negativos que hay que considerar cuidadosamente a medida que más y más organizaciones y empresas utilizan la inteligencia artificial generativa –en realidad machine learning predictivo y de probabilidad–, para 'aumentar' su periodismo.

Pero llegados a este punto, emerge ya una pregunta, un dilema que parece inevitable: ¿nos va a importar si lo escrito es de mucha calidad, el que no haya sido escrito y creado por un autor humano concreto? ¿O nos va a dar igual?

En fin, el periodismo automatizado aumentado algorítmicamente ya esta aquí de un modo que parecería que no vamos a poder rechazar, ni evitar... Al parecer, los impactos negativos de esta tecnología algorítmica sobre los lectores, las personas (también hay implicadas en todo esto 'tecnopersonas', como bien dice Javier Echeverría), y sobre nuestras sociedades democráticas, tendremos que detectarlas empíricamente y probablemente por dolorosas prueba y error.

Dada nuestra experiencia humana con el impacto que ya conocemos de las redes sociales sobre individuos y colectivos humanos, lo que se nos viene encima no pinta bien, que no nos pase nada. Sin embargo, en este caso, no se trata de un fenómeno climático extremo. Es una producción humana y cualquier consecuencia de ella, como sucede con todas las demás, no era, ni es, inevitable. Pero eso no quiere decir que consigamos evitar esta deriva que nos está invadiendo.