Imagen generada con inteligencia artificial sobre la regulación que afecta a esta tecnología en la Unión Europea. D+I.

¿Cumplen los modelos como ChatGPT o Bard con la ley europea de IA? La mayoría suspenden el examen

Modelos como GPT4- o PaLM 2 de Google apenas cumplen con la mitad de los requisitos establecidos en el último borrador conocido de la norma.

Con la aprobación de la AI Act, se abre ahora un exigente calendario para su entrada en vigor. Por lo pronto, la norma tiene que ser todavía refrendada por el Consejo de la Unión Europea y el Parlamento Europeo, lo que seguramente no suceda hasta ya pasado el primer trimestre de 2024. A partir de ahí, dos velocidades: las prohibiciones de los casos inaceptables entrarán en vigor en seis meses; el resto de la ley lo hará dentro de dos años.

Ese tiempo será oro para todos los proveedores y compañías que están desarrollando herramientas y soluciones de inteligencia artificial. Y es que, a día de hoy, la mayoría de los grandes modelos de IA que todos conocemos no cumplen con los requisitos del último borrador conocido de la ley.

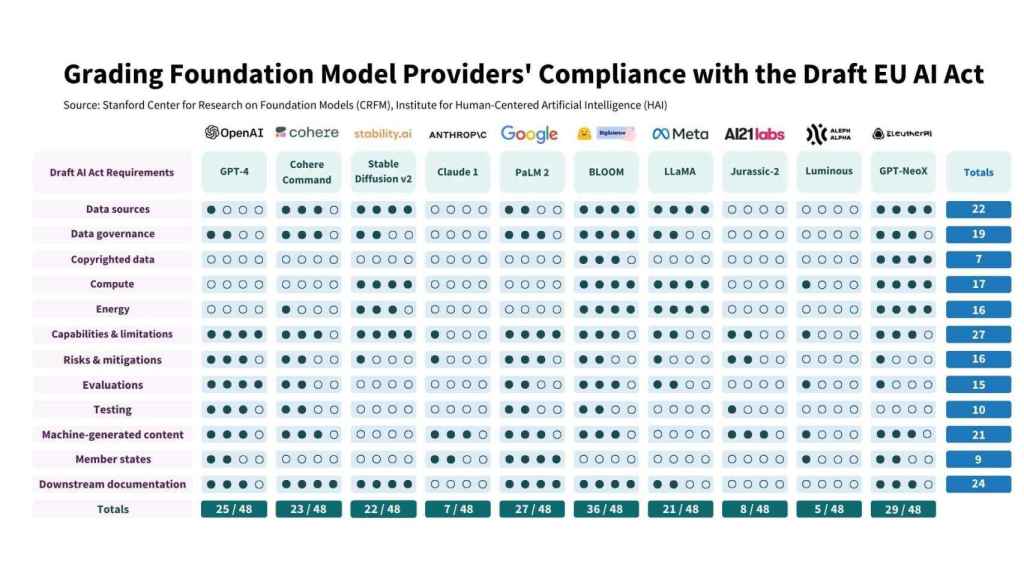

Así lo aseguran investigadores del Center for Research on Foundation Models de la Universidad de Stanford en un análisis realizado hace unos meses y que le fue presentado a la propia artífice de la AI Act, la secretaria de Estado Carme Artigas. Estos expertos han evaluado los diez principales modelos fundacionales -como ChatGPT, Llama, Bard, etc.- para constatar si cumplían con las premisas que los reguladores europeos introducirán en el ecosistema. Y la respuesta fue un contundente no.

Estos proveedores raramente divulgan información adecuada sobre el origen de sus datos, el cómputo y la implementación de sus modelos, así como las características clave de los modelos en sí. En particular, generalmente no cumplen con los requisitos de describir el uso de datos con derechos de autor en la capacitación, el hardware utilizado y las emisiones producidas durante ese entrenamiento. Tampoco cumplen en lo que atañe a cómo evalúan y prueban los modelos.

Los investigadores han comparado el comportamiento de GPT-4 de OpenAI, Cohere, Stable, Claude 1, PaLM 2 (usado por Google Bard), BLOOM, Llama de Facebook, Jurassic-2, Luminous y GPT-NeoX. De todos ellos, sólo BLOOM (impulsado por Hugging Face) consigue cubrir el 75% de los requisitos que impondrá la ley europea de inteligencia artificial. GPT-NeoX es el segundo contendiente, también relativamente desconocido, en conseguir una nota que supere el aprobado raspado, aunque ya bajando al 60% de cumplimiento.

¿Qué ocurre con los modelos más famosos? GPT-4, el moto detrás del popular ChatGPT, obtiene un aprobado raspado, ya que sólo cubre el 52% de las preocupaciones que han manifestado los reguladores europeos. PaLM 2, de Google Bard, es algo mejor, pero también tiene cubierto apenas un 56% de todas las exigencias de Bruselas.

De ahí, pasamos a los suspensos: ningún otro de los diez modelos analizados consigue siquiera cubrir la mitad de las demandas de la UE en este asunto. Por ejemplo, Llama, el modelo de inteligencia artificial generativa de Meta (ex Facebook) se queda en el 44% de cumplimiento, según los expertos de Stanford. E incluso Claude 1, el modelo desarrollado por Anthropic precisamente en respuesta a una mayor conciencia y responsabilidad en el uso de la IA, suspende de forma dramática al dar respuesta a tan sólo un 15% de los requisitos de la nueva norma.

"Nuestros resultados demuestran un notable rango en el cumplimiento por parte de los proveedores de modelos: algunos proveedores obtienen menos del 25% (AI21 Labs, Aleph Alpha, Anthropic) y solo un proveedor alcanza al menos el 75% (Hugging Face/BigScience) actualmente. Incluso para los proveedores con las puntuaciones más altas, todavía hay un margen significativo de mejora. Esto confirma que la ley producirá un cambio significativo en el ecosistema, logrando un progreso sustancial hacia una mayor transparencia y responsabilidad", concluyen desde Stanford.

Modelos abiertos 'vs' cerrados

Los expertos de Stanford también han observado una dicotomía clara en el cumplimiento de los requisitos de la UE en función de la estrategia de lanzamiento. Aunque estas estrategias no son binarias y existen en un espectro, por simplicidad consideran los modelos abiertos (por ejemplo, GPT-NeoX de EleutherAI, BLOOM de Hugging Face/BigScience, LLaMA de Meta) frente a los productos restringidos/cerrados (como PaLM 2 de Google, GPT-4 de OpenAI, Claude de Anthropic).

Grado de cumplimiento de cada modelo de IA con la ley europea, desglosado por cada requisito.

Y su conclusión es clara: las propuestas abiertas generalmente logran puntuaciones altas en los requisitos de divulgación de recursos (tanto de origen de los datos como de cómputo), con EleutherAI recibiendo una puntuación casi perfecta en estas categorías. Sin embargo, tales lanzamientos abiertos plantean desafíos para monitorizar o controlar su implementación, mientras que los lanzamientos más restringidos/cerrados conducen a mejores puntuaciones en requisitos relacionados con la implementación. Por ejemplo, PaLM 2 de Google recibe 11/12 en implementación.

D+I EN PROFUNDIDAD

Ley de Inteligencia Artificial

- La ley de inteligencia artificial llega a Europa, pero aspira a tener una vocación global

- Una ley que cubre un vacío legislativo, pero que es "mejorable": así valora el sector la nueva norma

- Ibán García del Blanco: "La ley de inteligencia artificial es el colofón al ecosistema legislativo digital europeo"

- 2024: el año del despliegue de la inteligencia artificial con un mercado capaz de aportar hasta cuatro billones de euros

- ¿Cumplen los modelos como ChatGPT o Bard con la ley europea de IA? La mayoría suspenden el examen

- Mil maneras de controlar la IA en las autonomías: estrategias, observatorios, leyes, clústers…

- Tres años dan para mucho: Carme Artigas, de la ley de startups al Reglamento de IA, la "guinda del pastel"

- Cinco retos de la ley de IA