Adam Selipsky durante su keynote en AWS re:invent 2023.

AWS lanza la IA generativa ‘Q’, que se lo sabe todo sobre la inmensidad de la nube

Servirá como guía y asistente para todo tipo de acciones, mientras la plataforma Bedrock soportará modelos LLM de otras tecnológicas.

3 diciembre, 2023 02:39Amazon Web Services (AWS) se sumerge también en la corriente dominante y se entrega a la pasión por la IA generativa. Lanza su propio modelo de lenguaje amplio, con nombre breve, sólo ‘Q’, y abre su plataforma Bedrock a la compatibilidad con los modelos de lenguaje amplio (LLM) de otras tecnológicas. Es la gran noticia de la magna conferencia re:Invent 2023, celebrada tradicionalmente en Las Vegas. Pero hasta llegar a eso…

“¿Estáis preparados para el primer anuncio del día?”, pregunta teatralmente, tras los primeros minutos de su keynote, el CEO de AWS, Adam Selipsky, a una audiencia que ya tiene levantadas las manos para aplaudir.

“Estoy emocionado por anunciar Amazon S3 Express One Zone, una nueva clase de almacenamiento S3 construida para lograr el mejor rendimiento y mínima latencia. Un almacenamiento en la nube para los datos a los que se accede con mayor frecuencia. Diez veces más rápido que el almacenamiento S3 estándar”, proclama el directivo, citando a Pinterest como testigo de su afirmación.

[Adam Selipsky, CEO de Amazon Web Services: "La mayoría de las cargas se moverán a la nube"]

Es una especie de ritual que se ha ido elaborando para realzar los grandes acontecimientos tecnológicos. Según el propio Selipsky, este año se han reunido en Las Vegas 50.000 asistentes en persona y otros 300.000 online. Los fieles, conocedores del rito, aplauden y vitorean con entusiasmo cada novedad, pero contando con que los primeros anuncios son sólo un calentamiento.

El CEO glosa luego las virtudes de su chip propio Graviton 3, en este caso mencionando a SAP, para anunciar una nueva generación del procesador creado por AWS y presentado hace cinco años. La cuarta versión tiene más de todo, flujos de trabajo un 40% más rápidos y hasta un 45% para ejecutar aplicaciones Java. La temperatura de la inmensa sala del hotel The Venetian sigue subiendo.

Supercomputadores exaescalares

Selipsky detalla a continuación acuerdos con Nvidia que le garantizan el suministro de potentes GPUs, para soportar inteligencia artificial y machine learning, integrando capacidades de virtualización. Un cliente “puede acceder hasta a 20.000 GPUs en un solo clúster… equivalente a un supercomputador”.

Sube al escenario el cofundador y CEO de Nvidia, Jensen Huang y se anuncia la incorporación de nuevas versiones de sus chips, con procesadores más potentes. “Muchas naciones se dan por contentas con disponer de un ordenador exaescalar y AWS tiene 3.000”, desliza Selipsky, que empieza a pronunciar palabras mágicas como “inteligencia artificial” y “entrenamiento de modelos de lenguaje amplio”.

AWS planea montar, con el proyecto Ceiba, una especie de súper supercomputador, un clúster con 16.384 GPUs Nvidia GH200, capaces de procesar 65 exaflops de IA. Es como si fueran 65 supercomputadores exaescalares.

Así, se va acercando el clímax. Aunque Selipsky todavía desgrana muchos minutos explicando cómo Salesforce, Adobe, Deutsche Telecomm, Leonardo y otras grandes tecnológicas aprovechan nuevas capacidades de la nube para su machine learning y entrenamientos de IA. El CEO de Anthropic, Dario Amodei, diserta en el escenario sobre la “IA segura”. Su compañía, creada por antiguos empleados de OpenAI, tiene un acuerdo estratégico de colaboración con AWS.

[Predicciones tecnológicas de AWS para 2023 y más allá, según Werner Vogels]

El entorno Bedrock, con el concurso de sus agentes y el generador CodeWhisperer para escribir código personalizado, será bastante agnóstico en el manejo IA generativa de diversos orígenes, asegura Selipsky. Empezando por el ejemplo delmodelo Llama, de Meta.

Y dicho todo esto, durante bastante más de una hora, Selipsky toma aire y eleva un poco el tono: “Hoy, estoy realmente orgulloso y emocionado al anunciar Amazon Q, un nuevo tipo de asistente con inteligencia artificial generativa, diseñado para trabajar por ti y facilitar rápidas respuestas, con interacciones en lenguaje natural. Podrás chatear, generar contenido y ejecutar acciones, todo ello con el conocimiento y comprensión de tus sistemas, repositorios de datos, operativa y, por supuesto, con una seguridad y privacidad sólidas como una roca”.

Sin haber tenido ocasión de preguntarle al CEO de AWS si ese nombre ‘Q’ es una especie de homenaje al jefe de investigación y proveedor de gadjets ultratecnológicos en las películas de James Bond, lo que sí queda claro es que esa nueva IA generativa aspira a ser un "chico para todo", capaz de operar a fondo en los laberínticos vericuetos de la nube de Amazon.

Y, naturalmente, la sala vitorea con exaltado entusiasmo el anuncio estelar.

Una IA experta en AWS

Sobre ‘Q’ subraya Selipsky como detalle clave que no sólo tendrá pleno conocimiento del sistema, también “entenderá las identidades para diferentes roles de tus permisos. Si el usuario no tiene permiso para acceder a algo sin Q, tampoco podrá hacerlo a través de Q”.

“Lo hemos diseñado para que atienda las necesidades del cliente corporativo desde el día uno y no permitiremos que el contenido propio que los clientes usen para entrenar a Q pueda usarse para el entrenamiento de modelos subyacentes”.

“Estoy convencido de que va a ser transformador. Esperamos que montones de diferentes tipos de gente hagan diferentes tipos de tareas beneficiándose de Q”, prosigue Selpisky que habla de “reinventar el trabajo”.

“Hemos entrenado a Q con el conocimiento de 17 años de funcionamiento de AWS, para que facilite la optimización de las aplicaciones y cargas de tarea y ponerlo donde trabajas, de modo que pueda ayudarte a manejar la consola, documente tu entorno de desarrollo [IDE] a través de CodeWhisperer y puedas usarlo en un chat para explorar las capacidades, tecnologías y soluciones de arquitectura de AWS”.

El concepto es que, en un entorno que ofrece millares de servicios, aplicaciones y opciones de almacenamiento, la nueva inteligencia de ‘Q’ sea una clarificadora guía de consulta para identificar cuáles de ellas son las más apropiadas y útiles para el desarrollo de una determinada actividad.

“Q es un experto en AWS y también en patrones de arquitecturas, buenas prácticas, soluciones y peticiones. Puedes preguntarle cómo construir una aplicación web y cuáles son las opciones para sacarle provecho. Pedirle instrucciones paso a paso y links relevantes”, concreta Selipsky.

Recomendaciones y soluciones

Además, la inteligencia de Q va a ser capaz de resolver problemas, identificar las conexiones y analizar la red de punta a punta para solucionar dificultades de conexión. “También puedes preguntarle para elegir las instancias optimas, según las necesidades. Puede recomendar, por ejemplo, qué tipo de instancias EC2 dan el mejor rendimiento para codificar vídeo y trascodificar cargas de trabajo, para casos de videojuegos. Es muy fácil de usar y muy cool”.

Selipsky asegura que la nueva IA de AWS “va a ahorrar mucho tiempo e inconvenientes a los clientes. No sólo optimizará las tareas. También puede estar presente en el IDE para ayudar a los desarrolladores, si no están familiarizados con el código para algunas funciones específicas. Q, con CodeWhisperer, les ayudará a acelerar, entendiendo su código, mediante consultas de texto. CodeWhisperer generará partes de código para ahorrar tiempo y Q automatizará las tareas de desarrollo en múltiples pasos”.

[AWS dedicará 100 millones de dólares para que su alternativa a ChatGPT llegue a las empresas]

Por si acaso, también aclara que el cliente mantendrá “el control” con su propia experiencia, para asegurar la calidad del resultado. “No es posible manejar hoy en día otro asistente IA, de cualquier otro gran proveedor de la nube, capaz de hacer todo eso por ti”, afirma triunfante el CEO de AWS, tras informar de que el uso a través del prompt de Code Catalyst ya está disponible. Y muy pronto lo estará en el IDE.

“¿Eso es todo?”, se pregunta Selipsky. Pues no: “Sabemos que los desarrolladores pierden mucho tiempo con el mantenimiento y las actualizaciones de los lenguajes [de programación]. Muchos siguen usando viejas versiones de Java porque puede costar meses actualizarlo todo. Con las migraciones ocurre muchísimo y se consumen toneladas de tiempo reescribiendo viejo código, compilándolo… una y otra vez, en un bucle infinito. Y pendientes de posibles vulnerabilidades de seguridad. Pues para eso hemos desarrollado Q conversor de código, que ayudará a actualizar y transformar el código en una fracción de tiempo de lo que cuesta ahora”.

“Todo lo que el desarrollador tendrá que hacer es un formulario de transformación y [Q] manejará el resto, identificando y actualizando el código, los repositorios y marcos de trabajo, localizando el código obsoleto y añadiendo las mejores prácticas de seguridad. Además, correrá tests con lo actualizado. Lo hemos probado internamente y los resultados son asombrosos. Un pequeño equipo de desarrolladores ha actualizado miles de aplicaciones de Java versión 8 a 17 en sólo dos días. Son meses de trabajo de programador…”.

“Y que pasa con el resto de la gente en vuestra organización, los de márketing, financiero, recursos humanos, gestión de producto…”, continua Selispky, ya entre ovación y ovación. “Pues si tienen que pelearse cada día con la búsqueda de información dispersa por diversos documentos, para tomar decisiones o hacer lo que sea, en diferentes posiciones, Amazon Q es también el experto en negocio. Está conectado con más de 40 de los más populares sistemas de negocio”.

“Así que los empleados pueden hacer preguntas complejas y obtener respuestas detalladas, precisas y matizadas, relevantes para su posición y acordes con su grado de autorización”, remacha el CEO, dejando para su vicepresidente Swami Sivasubramanian la presentación de Titan Image Generator, otro LLM de AWS, capaz de generar imágenes a partir de una descripción de texto, cuidándose de los derechos de autor e incluyendo invisibles marcas de agua.

Desde este re:Invent, AWS habla de sus propias “familias de IA generativa”. Conocida su prolífica capacidad de multiplicación, cabe pronosticar que en poco tiempo habrá en su nube decenas de inteligencias distintas para elegir la más lista según el caso.

Una enmienda a la moda de la IA

El CTO de AWS, Werner Vogels, es un auténtico rock star, cuya keynote se espera con verdadero fervor en la conferencia. Siempre pone una nota de originalidad y abre puertas al futuro. Pero en esta ocasión su presentación mantuvo desconcertada a la concurrencia durante más de una hora, haciendo historia de la evolución de la nube.

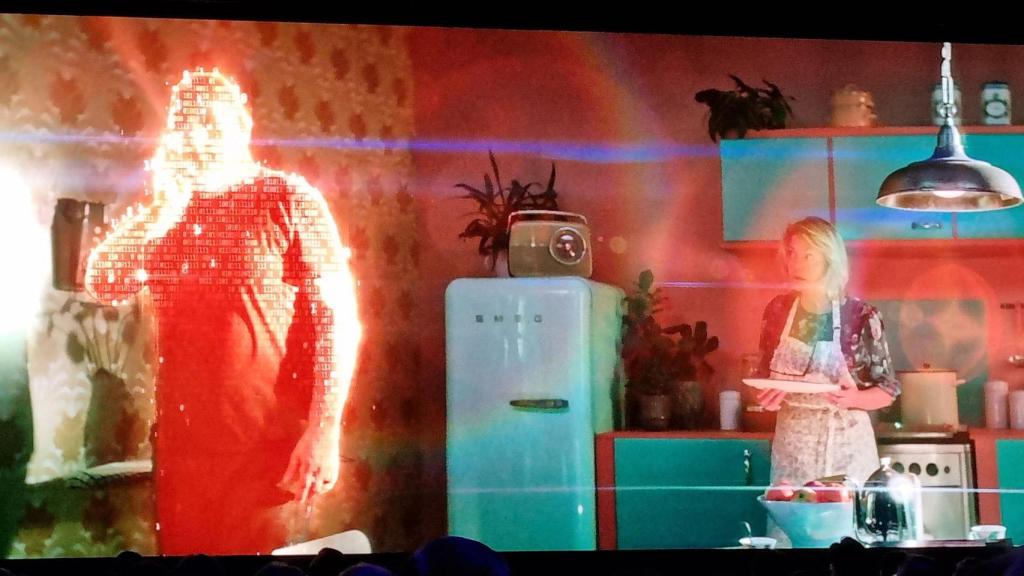

Este periodista lo interpreta como una enmienda a la totalidad de la tendencia a convertir ahora la IA en una moda desbocada. Vogels subraya que sus inicios datan, nada menos, de 1956. El CTO inició su presentación con un vídeo satírico en el que envía a la nube al ‘Gran Arquitecto’, para que no gaste demasiado en renovar su hardware creativo.

Y para cerrar, Vogels ofreció otro vídeo burlón, en el que una 'futurista'le pide predicciones sobre tecnologías rompedoras para pasado mañana. La recomendación del CTO es, sin disparatarse con adivinanzas: “para predecir el futuro, observa la actualidad”, en busca de soluciones prácticas para el mundo real. O sea, conviene seguir entendiendo la IA simplemente como una potente herramienta en la que apoyarse.

Werner Vogels diluyéndose en una imagen digital, en el vídeo que ha puesto como cierre de su keynote.