Darío Gil, director de IBM Research, y Mikel Díez, director de Innovación de IBM España, Portugal, Grecia e Israel de IBM.

Los dos españoles que aterrizan la computación cuántica para que sea real: Darío Gil y Mikel Díez

Ambos trabajan en IBM, uno en Estados Unidos y otro desde nuestro país. Y ambos quieren que los ordenadores cuánticos abandonen el laboratorio.

15 mayo, 2023 02:51Decir que Darío Gil es murciano y uno de los principales investigadores españoles en el campo de la computación cuántica es quedarse corto. Desde Estados Unidos, Gil lidera la histórica IBM Research con 3.000 investigadores a su cargo y ha conseguido posicionar a esta multinacional a la cabeza de esta innovación a escala global.

Nos encontramos con él en San Sebastián, con motivo del anuncio de que uno de sus 'juguetes' se instalará en la región. Allí reconoce que la aventura que inició hace ya bastantes años está cobrando al fin el cáliz que tanto anhelaba: "Estamos viendo cómo se crea una nueva industria, delante de nuestros ojos. Cuando creamos el primer ordenador cuántico, no sabíamos si iba a salir adelante, porque tan sólo tenían acceso a ellos siete u ocho grupos de investigación en el mundo. Y ahora hemos sido capaces de crear una comunidad global, lanzado sistemas nuevos cada año y cosechando un crecimiento exponencial".

Con Mikel Díez el encuentro también se produce en un marco excepcional: el Mobile World Congress. El bullicio es constante. El rumor de personas compartiendo opiniones y experiencias no cesa mientras Díez mantiene la conversación con D+I. Se trata del responsable de innovación de IBM en España, Portugal, Grecia e Israel, y su equipo colabora estrechamente con el propio Darío Gil.

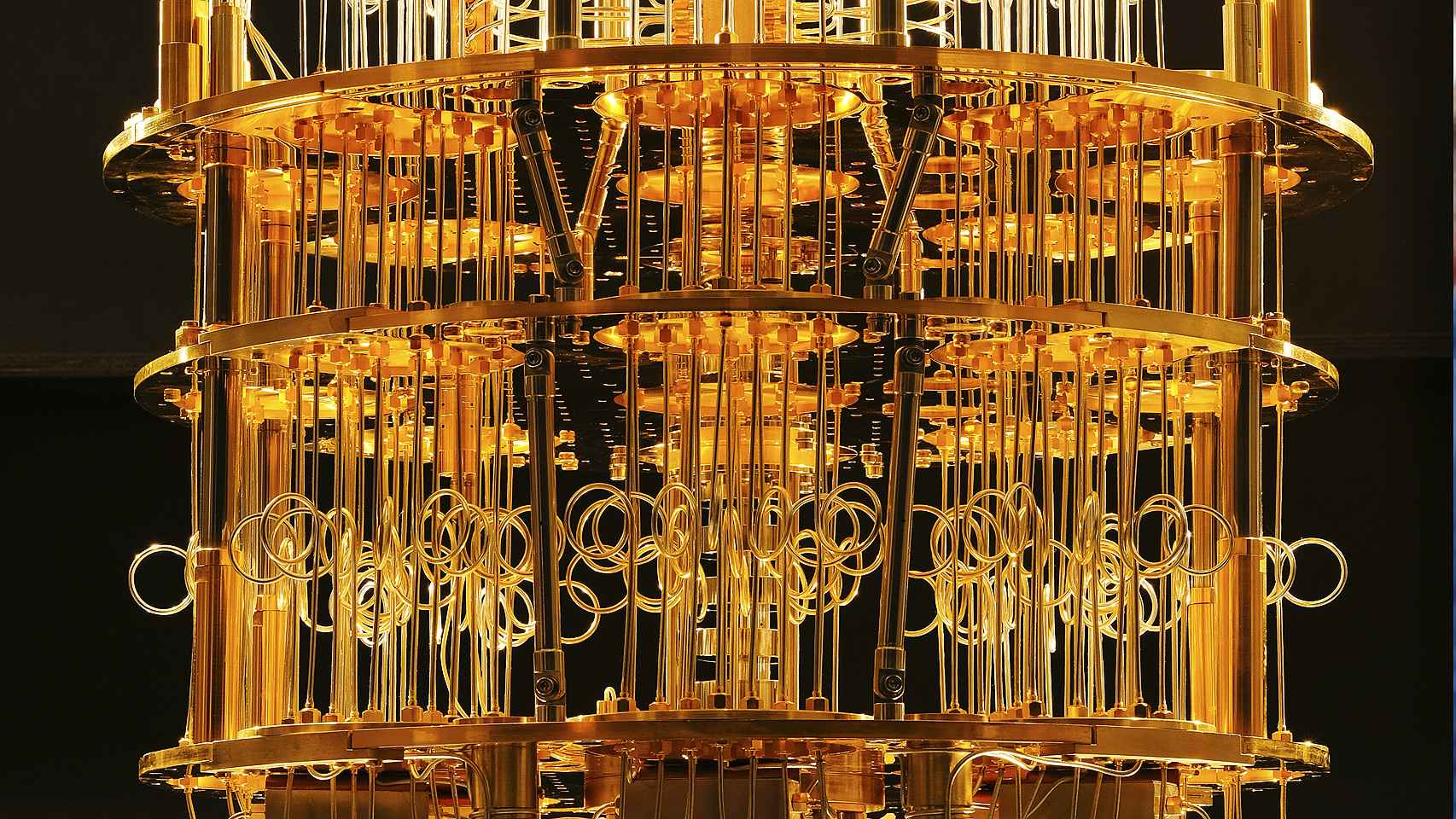

“Está en nuestro ADN invertir en computación cuántica, ya no nos dedicamos a fabricar servidores, ordenadores ni impresoras, como hacíamos hace unos años”, apunta. “Seguimos siendo el fabricante líder en supercomputación y en grandes mainframes, con un histórico de décadas en el desarrollo de semiconductores, una tecnología que utilizamos en la computación cuántica. Sabemos cómo hacer los cúbits, toda la electrónica de red para gobernarlos, toda la criogenia para que ‘estén quietos’… Y esto hace que nos estemos adelantando a nuestras predicciones”.

Entre lo posible y lo imposible

Darío Gil presume de representar a la única compañía que ha "compartido una hoja de ruta con la comunidad sobre la computación cuántica en esta vertiente industrial. Nadie lo había publicado antes. Tampoco nadie había pasado de los 100 cúbits en el mundo de los superconductores, y nosotros lo conseguimos hace dos años. Somos los pioneros en muchos campos, ya no sólo de la computación cuántica, sino de tecnologías y metodologías paralelas".

Darío Gil (IBM Research), el consejero de Educación, Jokin Bildarratz, y el presidente de IBM, Arvind Krishna

Se refiere Gil a los avances en comunicaciones entre distintos sistemas cuánticos que permitan vencer las fronteras de lo posible y lo imposible. "Este año tendremos 1.000 cúbits en un sólo chip y seguramente estaremos cerca del límite de los números. Por eso empezamos a diseñar principios de modularidad y a conectar unos sistemas con otros, al principio por comunicaciones cuánticas y en un futuro con tecnologías también cuánticas".

Reducir el error

Ahora al reto al que se enfrentan es ingente: “Es importante tener un volumen de cúbits, pero también que sean estables, que tengan buena tolerancia a los errores y que sean capaces de hacer muchas operaciones en un tiempo muy reducido. Sólo así podremos tener algoritmos que resuelvan esos grandes problemas que la computación clásica es incapaz de solucionar”, detalla Díez.

Con ello se refiere a la simulación de sistemas naturales, entender cómo se comportan las proteínas o las moléculas, o predecir los riesgos a futuro de una entidad financiera para evitarlos. Para lograr estos objetivos, “estamos trabajando no sólo en un único procesador, sino en tener varios procesadores y ‘coserlos’ con comunicación clásica”.

“Así, reducimos mucho la tasa de errores, con cada 1.000 operaciones con cúbits, una es errónea. Pero lo más relevante no es que hacemos cúbits mejores, si no que aplicamos inteligencia artificial para mitigar los errores que se producen, prediciéndolos e incluso que podamos corregirlos”, explica Díez entusiasmado.

"Hay tres grandes dimensiones que son importantes: la cantidad, la calidad y la velocidad. Esas tres cosas son fundamentales para determinar una tecnología que tenga valor", refrenda Darío Gil. "La calidad por supuesto que es clave. Si uno no es capaz de mejorar el nivel de coherencia, el nivel de fidelidad y luego implementar técnicas de mitigación de errores y, en el futuro, técnicas de corrección de errores completas, pues no puedes utilizar la cantidad de cúbits disponible".

[Así será el primer computador cuántico de 4.000 cúbits]

"Pero no se aprecia a veces la cantidad de ciencia e ingeniería que son necesarias para avanzar en las tres dimensiones a la vez", reconoce el directivo murciano. "Nuestra metodología científica y tecnológica se basa en ir avanzando estas dimensiones en paralelo, incluyendo áreas como la electrónica de control o el uso de nuevos materiales que reemplacen al dióxido de silicio del transistor, para luego llegar a momentos de unificación de todas ellas".

Las técnicas de mitigación de errores son, por el momento, la gran baza con la que juega IBM para sortear los impedimentos que la mecánica cuántica pone en las ruedas de la calidad de estos sistemas. "Con el primer computador que lanzamos teníamos un nivel de tres a cuatro errores por cada cien operaciones. Ahora ya hemos hecho demostraciones de niveles de errores de diez elevado a menos tres", añade Gil.

Mikel Díez, director de Innovación de IBM España, Portugal, Grecia e Israel IBM.

Ese uno de cada 1.000 al que hacía referencia su compañero Mikel Díez, pero que el Gigante Azul todavía quiere reducir hasta que estemos en un error por cada 10.000 operaciones. "La gente decía hace poco que aún quedaba una década o dos para alcanzar ese estado, pero yo creo que va a pasar este mismo año", pronostica el director de IBM Research.

Y va más allá Darío Gil al desmontar los argumentos de los críticos con la carrera que está siguiendo su firma en este campo: "Hay gente que dice que lo que tenemos ahora no guarda ningún valor, con las técnicas de mitigación de errores. Pero no vamos a llegar un día y tener una máquina de un millón de cúbits sin error alguno. Así no es como se han generado los avances en la historia de la informática".

No estamos hechos para caminar en soledad

En estos momentos, el desarrollo tecnológico de los computadores cuánticos y toda la ingeniería que lo rodea -como la refrigeración extrema, por ejemplo- sigue estando en un estado muy incipiente. De ahí que IBM se ocupe de diseñar y producir todas las capas de estos equipos, algo que se contradice con la tradición de esta enseña de centrarse en los elementos de más valor de cada dispositivo.

Darío Gil reconoce que, precisamente, las intenciones de la multinacional pasan por encontrar compañeros de viaje que los acompañen en esta travesía: "El objetivo no es que IBM mantenga el 100% del computador cuántico, sino comprar a empresas especializadas aquellas partes que no aporten valor extraordinario al producto final".

¿Con qué se quedará IBM de estos equipos, cuando alcancen su mayoría de edad? "En general, hay tres partes que son cruciales. El procesador y su ensamblaje final, el software y su interconexión con el mundo clásico", adelanta el ejecutivo.

En busca de los casos de uso

Entre las empresas que utilizan sus máquinas (en total seis, incluyendo la que presentó IBM en el País Vasco recientemente, y que se suma a las de EEUU, Japón, Canadá, Corea del Sur y Alemania) las hay de los sectores industrial, banca, aerolíneas, utilities, telecomunicaciones, universidades e incluso startups.

Las aplicaciones de la computación cuántica son tan variadas como lo sectores a los que pertenecen la compañías que trabajan con ella. El fabricante LG, por ejemplo, está investigando para empezar a fabricar sus pantallas de plasmas con componentes orgánicos y no con tierras raras. Mientras que Daimler-Mercedes pretende mejorar las baterías de los coches eléctricos “para que se degraden menos con el frío, tengan más autonomía o se carguen más rápido”, describe Díez.

"Con los ordenadores cuánticos queremos complementar la computación clásica, no sustituirla"

Una firma de utilities, de la que no trasciende su nombre, aplicará esta tecnología para decidir dónde instala sus molinos de viento y que la estela que generan no impacte en el resto. “Ahora mismo sólo es posible determinar dónde poner la primera línea y la segunda fila de estas instalaciones, porque no tenemos capacidad cuántica para analizar todas las variables”, explica el investigador español.

En España, colaboran con la Diputación de Vizcaya. “Allí estamos trabajando con corporaciones y startups para optimizar la recogida de residuos o mejorar las rutas de autobuses sacando patrones para saber por qué lugares es mejor pasar más o menos”.

Y en el marco del MWC no podía faltar una mención a las ventajas para las operadores de telecomunicaciones y lo que la cuántica puede aportar a este sector, donde el siguiente salto no sólo será aportar menos latencia y más ancho de banda, “también tendremos que contar con redes más seguras para, por ejemplo, gestionar la identidad digital y garantizar la integridad de los datos. Es lo que ya se ha dado en denominar ‘criptografía postcuántica’, resistente a ataques que se generen con ordenadores cuánticos”.

A este respecto, Darío Gil reconoce que, "desde el primer día", era consciente de las consecuencias que la computación cuántica podría tener sobre los sistemas de cifrado actuales. "Por eso lo que hicimos fue dedicar un gran esfuerzo de investigación, trabajo y colaboración para encontrar alternativas a esos sistemas", concreta.

Cuándo alcanzaremos la ventaja cuántica

Durante la conversación es inevitable mencionar cuánto tardará esta tecnología en estar disponible para transformarla en conocimiento. La respuesta no se hace esperar: “La computación cuántica ya existe, otra cosa es que lo que queremos hacer con ella sea posible ahora”.

Interior de un ordenador cuántico de IBM.

Díez pone a su propia compañía como ejemplo, con más de 400.000 personas registradas de más de 200 corporaciones accediendo a sus ordenadores cuánticos, que ejecutan alrededor de 1,4 billones de circuitos cuánticos al día. “Otra cosa es que estemos sacando ventaja cuántica”, añade.

En esta multinacional prefieren usar el término “ventaja cuántica” y no “supremacía cuántica” empleado por otras compañías que están en esta carrera, porque apuestan por un escenario híbrido, donde la computación cuántica no ha venido a sustituir a la clásica, “si no a complementarla haciendo algo que sabe hacer muy bien: gestionar escenarios con un uso exponencial de los datos”, explica el directivo de IBM.

Una aproximación, la de abandonar el concepto de "supremacía cuántica", que enfrenta frontalmente a IBM con algunos rivales, como IBM, que incluso afirmaron haberla alcanzado en el pasado. "Cuando miremos hacia atrás, muchos de estos experimentos no sobrevivirán a la revisión histórica. Ya empezamos a ver algunos ejemplos de ventaja cuántica, pero todavía queda mucho esfuerzo desde la física teórica y la aplicada para conseguirla", defiende a su vez Darío Gil.

"Tenemos que seguir trabajando en esta línea, que sabemos de sobra que es una frontera tecnológica con mucho riesgo y todavía mucha incertidumbre. Pero es el principio de un camino que nos llevará muchas décadas recorrer hasta alcanzar su máximo potencial. Según los proyectos, lo que hacemos hoy no verá la luz hasta dentro de cinco o diez años, pero debemos invertir igual", sentencia el máximo responsable mundial de esta división.

Los orígenes de la computación cuántica.

Aunque la computación cuántica haya saltado recientemente a la primera plana mediática, lo cierto es que debemos buscar sus antecedentes hace ya más de 30 años.

Entonces, un tal Richard Feynman planteaba los principios de la mecánica y la electrodinámica cuántica que, a la postre, darían vida a los ordenadores cuánticos que hoy nos ocupan. Equipos muy distintos de los PC que todos tenemos en nuestras casas y oficinas, porque son capaces de incorporar los distintos estados de los fotones o electrones (las partículas esenciales que se usan en lugar de chips) dentro de un mismo dispositivo.

Dicho de otro modo: estamos ante máquinas que funcionan por superposición (esto es, cuando dos cúbits presentan los dos valores de forma simultánea, multiplicando su capacidad de procesamiento) y entrelazamiento (de modo que dos o más cúbits estén conectados entre sí). Gracias a estos computadores cuánticos, podremos abordar temas complejos que hasta ahora eran imposibles de resolver. Por ejemplo, podremos hacer simulaciones más rápidas y precisas de nuevos materiales o medicamentos, de cientos de años a apenas horas. También, veremos ordenadores que podrán ellos solos analizar el riesgo de sus clientes en milésimas de segundo.

"La computación cuántica nos dará el poder de llevar a cabo cálculos mucho mayores", explicaba en entrevista con D+I Ignacio Cirac, considerado el padre mismo de la computación cuántica y eterno candidato al premio Nobel. "Muchos de los casos de uso de los supercomputadores actuales serán también los de los computadores cuánticos: ciencia, materiales, biomedicina... Pero también otros relacionados con la optimización o el análisis de grandes volúmenes de datos".

IBM, Google, Intel, Alibaba, Tencent, D-Wave y Rigetti fueron los primeros nombres que se lanzaron a la arena de la computación cuántica con sus equipos (después de las universidades y centros como el Max Planck europeo).