Zaira Nazario, líder técnico de teoría y aplicaciones cuánticas en IBM Quantum.

Zaira Nazario (IBM Research): "La cuántica promete resolver problemas imposibles para las computadoras más poderosas"

En esta entrevista con D+I, la investigadora señala la computación cuántica como "tecnología transformadora y sin analogía clásica".

24 enero, 2022 03:55Noticias relacionadas

Zaira Nazario (Puerto Rico) es física teórica y comenzó a trabajar en computación cuántica hace más de una década. Desde 2017 forma parte del equipo de investigadores de una de las grandes tecnológicas con más recorrido: la centenaria IBM.

Con los teóricos de IBM Quantum se dedica, desde hace casi cinco años, a "entender y desarrollar lo que necesitamos para ver las ventajas de la computación cuántica: aplicaciones, algoritmos, mitigación y corrección de errores...", cuenta a D+I desde el IBM T.J. Watson Research Center, de Nueva York (Estados Unidos).

En la entrevista con este medio también confirma que trabaja con el vicepresidente sénior de IBM y director de IBM Research, el español Darío Gil, "en varios aspectos técnicos y científicos de la organización".

Antes de recalar en el 'Gigante Azul', Nazario pasó por el Instituto Max Planck para la Física de Sistemas Complejos en Dresde (Alemania). También trabajó formando y gestionando programas de investigación y desarrollo de computación cuántica para Departamento de Estado de EE. UU. y las agencias estadounidenses DARPA (Defense Advanced Research Projects Agency) e IARPA (Intelligence Advanced Research Projects Activity), "lo cual implicaba trabajar con los grupos líderes de computación cuántica a nivel mundial".

"Siempre me interesó mucho el tema de los errores en las operaciones cuánticas y cómo detectarlos y corregirlos", confiesa. Y fue así cómo comenzó a trabajar más de cerca con el grupo de IBM.

Ensamblado de IBM Quantum System One. Omicrono

Con la experiencia acumulada en su trayectoria profesional, ¿varía mucho el trabajo de investigación en un organismo público al que se realiza en una empresa privada?

Hay semejanzas y diferencias, principalmente en el ambiente en el que trabajas y la filosofía. Un lugar como el Max Planck es increíblemente rico en colaboraciones y variedad de áreas, debido a la cantidad de científicos internacionales que pasan largos periodos de tiempo colaborando y la libertad de la que se disfruta en la investigaciones.

En agencias de gobierno y laboratorios nacionales se tienen más en cuenta los intereses del colectivos por encima de las investigaciones individuales, y eso está presente siempre.

La investigación versa sobre cómo beneficiar a una nación y sacar el mayor provecho de la inversión de los contribuyentes. La investigación en una compañía privada está más enfocada hacia aspectos con potencial comercial alineados con la estrategia y misión de la empresa.

¿Qué ha aprendido de su paso por el sector público que ahora está aplicando a una empresa privada?

Agencias como DARPA e IARPA en el sector público no sólo están cómodas en un entorno con más riesgo, sino que su propósito es apostar por cosas con un potencial muy grande y tan inciertas que muy pocas son exitosas. pero las que lo son traen beneficios enormes. Buscan, además, reducir la burocracia todo lo posible. Esa es la primera lección, eliminar burocracias innecesarias y no tener una visión 'miope' por culpa de la aversión al riesgo.

Haber trabajado en el sector público me lleva a desarrollar tecnología que derive en el mayor beneficio para los usuarios y el mayor valor económico posibles.

Otras lecciones que se aprende son, por ejemplo, pensar sobre las consecuencias de las cosas en lugar de tener una creencia más propia del sector privado, que sigue la filosofía de 'move fast and break things'; trabajar óptimamente en ambientes inciertos; el arte del compromiso —o no— en los momentos apropiados en beneficio de lograr una visión; el arte de la comunicación, tanto oral como escrita.

Además, haber trabajado en el sector público me da una perspectiva valiosa que me lleva a buscar cómo la tecnología que estamos desarrollando derive en el mayor beneficio para los usuarios y el mayor valor económico posibles. Esto es algo que es fundamental en el sector público, donde eres responsable de qué se hace con el dinero de los contribuyentes.

Su área de especialización es la computación cuántica, ¿en qué punto está esta tecnología? ¿Por qué es necesario su desarrollo?

La computación cuántica está en una etapa de desarrollo relativamente temprana, pero ha evolucionado muchísimo en los últimos años y está avanzando rápidamente. En 2016, cuando pusimos en la nube el primer procesador cuántico, era de apenas 5 cúbits. Hoy día tenemos un procesador de 127 cúbits y este año lanzaremos uno de 433 cúbits.

En términos de calidad de operaciones, hemos alcanzado el nivel de un error por cada 1.000 operaciones cuánticas en sistemas de docenas de cúbits. Hemos mejorado la velocidad de ejecución de simulaciones cuánticas en nuestros sistemas hasta hacerla, en algunos casos, más de 100 veces más rápida.

La cuántica es una tecnología transformadora. Se trata de un paradigma de computación fundamentalmente diferente y sin analogía clásica.

Para dar una idea de lo que significa todo esto, existe una indicación teórica que señala que, con varios cientos de cúbits capaces de operar con solo un error por cada 10.000 operaciones cuánticas, podemos simular sistemas físicos con una ventaja cuántica sobre la computación tradicional.

Esto es una tecnología transformadora. No se trata de una mejoría incremental en computación, de cómo añadir más transistores o multiplicar el clock-speed. Se trata de un paradigma de computación fundamentalmente diferente y sin analogía clásica.

Ese nuevo paradigma nos trae la promesa de resolver problemas computacionales que son imposibles incluso para las supercomputadoras más poderosas y que son importantes para la ciencia, la tecnología y la industria; con un potencial de beneficios muy grande para nuestras vidas, el planeta y futuras generaciones. Por eso es tan importante no solo continuar, sino acelerar su desarrollo.

Entre los últimos hitos anunciados por IBM está el nuevo procesador Eagle de 127 cúbits, ¿qué significa este avance?

Es un paso importante en el escalamiento de las computadoras cuánticas. Representa un gran adelanto en el problema del empaquetado de los procesadores, para permitir llevar eficientemente las señales de microondas necesarias para controlar cada cúbit en el chip y escalar sin sacrificar rendimiento.

Además, al pasar de 100 cúbits, significa que estamos en el nivel donde ninguna computadora tradicional, por poderosa que sea, puede simular lo que hace el estado entrelazado de todos los cúbits en el procesador.

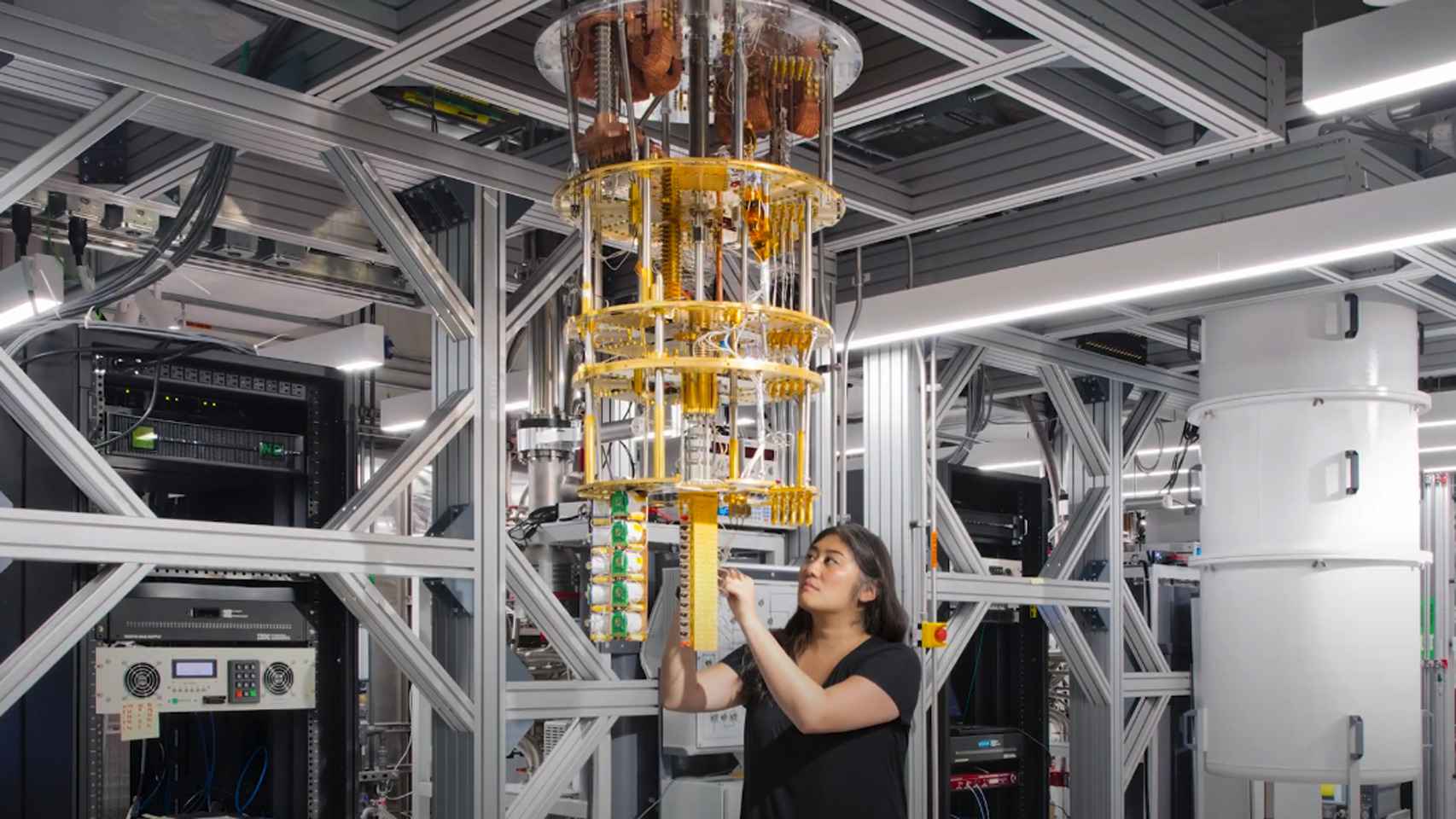

El primer ordenador cuántico comercial de IBM en Europa se ha instalado en el instituto alemán Fraunhofer-Gesellschaft.

La hoja de ruta de IBM en este área recoge que para este 2022 está previsto lanzar, como adelantaba antes, el sistema Osprey de 433 cúbits y en 2023 el Condor de más de 1.100 cúbits, ¿cuáles son los principales desafíos que se resolverán? ¿Cómo es posible que se escale tan rápido?

Cada uno de nuestros procesadores resuelve un problema esencial para el escalamiento del hardware. Con Osprey se estará mejorando la densidad de líneas de control que entran y salen del refrigerador de dilución donde se alojan los cúbits. Esto es fundamental para poder seguir aumentando el número de cúbits.

A la vez estaremos miniaturizando y mejorando la electrónica necesaria para controlar los cúbits. Condor se enfocará a la integración eficiente en grandes escalas mientras se mejora la fidelidad de las operaciones cuánticas que es capaz el procesador.

Todos estos avances tan rápidos sólo son posibles gracias a las décadas de experiencia que posee IBM en el escalamiento de CMOS y semiconductores, a las grandes inversiones en la infraestructura sofisticada necesaria para escalar la computación cuántica y al gran talento de nuestros investigadores e ingenieros, que son líderes a nivel mundial.

Condor, de más de 1.100 cúbits, se enfocará a la integración eficiente en grandes escalas mientras se mejora la fidelidad de las operaciones.

El camino hacia el desarrollo de la computación cuántica no puede recorrerse en solitario. Una de las últimas alianzas anunciadas por su compañía es la unión de LG a su red. ¿en qué consiste esta colaboración?

Tienes toda la razón, si queremos acelerar el progreso en el desarrollo de la computación cuántica, no podemos hacerlo solos. De eso trata la colaboración con LG, de acelerar el progreso hacia la ventaja cuántica en problemas de importancia comercial.

LG usará nuestras computadoras cuánticas y herramientas de software para, en colaboración con los expertos de IBM, explorar los beneficios de la computación cuántica en su negocio y operaciones. En particular, el énfasis se hará en la combinación de computación tradicional con cuántica para extender la capacidad computacional y los problemas que se pueden resolver.

Se trata de investigar cómo el todo de la computación clásica más la cuántica es más poderosa que la suma de las partes. Otro aspecto muy importante es la educación y el desarrollo de destrezas en computación cuántica que, trabajando con IBM, LG estará proveyendo a sus empleados.

¿Qué aplicaciones prácticas explorará LG con esta tecnología?

LG explorará la utilidad de circuitos cuánticos para mejorar procesos de aprendizaje automático; por ejemplo, proveyendo más precisión. Como sabemos, los modelos de aprendizaje automático aplican a una variedad amplia de problemas. En el caso de LG, la robótica podría ser un ejemplo. En realidad, el inicio de la colaboración con IBM se tratará precisamente de identificar cuáles son los casos de uso con mayor potencial y mejor alineados a la estrategia de LG.

Desde que en 2016 pusimos el primer procesador cuántico en la nube, se han publicado más de 700 artículos de investigación científica de personas externas a IBM.

Sobre el resto de los clientes de la IBM Quantum Network, ¿cuáles son las principales investigaciones y usos que están llevando a cabo?

En el IBM Quantum Network estamos viendo a nuestros socios aplicando la computación cuántica en la simulación de procesos químicos y termodinámicos para el diseño de materiales; por ejemplo, para aquellos resistentes a la corrosión, el desarrollo de materiales y procesos con ventajas energéticas, mejoras en el entrenamiento de modelos de aprendizaje automático y su aplicación para la clasificación de datos, y para hacer mejores análisis y predicciones.

En la industria financiera investigan su uso, por ejemplo, en el análisis de riesgo y estamos viendo, además, investigaciones para problemas aeroespaciales.

¿Cuáles serán los principales impactos de la computación cuántica en el futuro? ¿Cuándo llegarán?

El primer impacto que hemos visto ha sido en la educación. Ha habido una explosión de interés por aprender sobre computación cuántica, aprender a programar, e incorporar esta materia en los currículos. Además, vemos su impacto como instrumento científico. Desde que en 2016 pusimos el primer procesador cuántico en la nube, se han publicado más de 700 artículos de investigación de personas externas a IBM utilizando nuestros sistemas cuánticos. Eso lo estamos viendo ya hoy.

En el futuro, probablmente uno de los impactos más importantes estará relacionado con la simulación de la naturaleza, por ejemplo, permitiéndonos resolver problemas en física, química y ciencia de materiales. Esperamos ver un impacto en el procesamiento de datos con estructura, aquí hablamos de mejorar el aprendizaje automático y la clasificación de grupos.