Cuando una persona ve una imagen, automáticamente tiene la capacidad de reconocer y resumir lo que está ocurriendo en unas pocas palabras, sin necesidad de describir con detalle cada uno de los elementos que aparecen en la escena. Esto, que puede parecer muy sencillo, no lo es tanto para los ordenadores y entre otros proyectos, es en lo que trabajan en el departamento de investigación de Google.

Resumir en pocas palabras escenas complejas, ese el objetivo que buscan desde Google y para ello han desarrollado una maquina con capacidad de aprendizaje, utilizando una sistema de red neuronal recurrente, capaz de poner un pie de foto a imágenes automáticamente, describiéndola tal y como lo haría un humano.

Ayudar a personas con discapacidad y más potencia para el buscador de Google

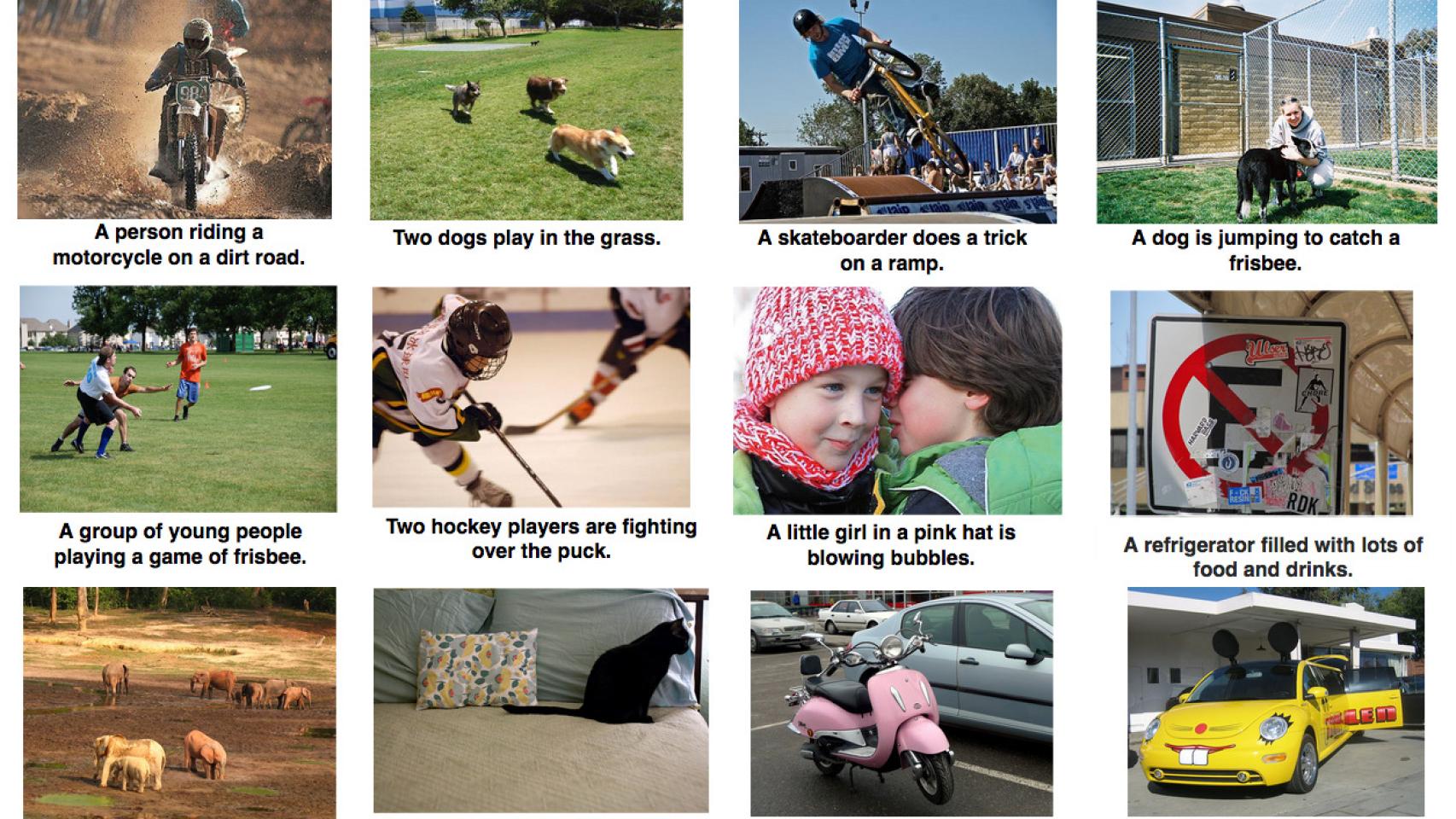

La máquina analiza la foto en busca de elementos que le permitan realizar su resumen en texto, pero para ofrecer resultados precisos alimentarán al sistema de imágenes ya descritas por humanos. El proyecto es muy ambicioso, principalmente porque además el resultado escrito debe tener un sentido humano, no basta con poner el nombre de objetos, sino que debe ser coherente. Por supuesto, por ahora tiene errores, como se puede ver en la imagen superior, donde omite o confunde objetos.

Con un sistema como este, en el que los textos fueran fieles a la realidad, donde las máquinas pudiesen reproducir el contexto de una imagen al verla, permitiría ayudar a personas con discapacidad visual a entender fotografías e imágenes y, también, Google podría aprovechar todo su potencial para aplicarlo al motor de su buscador. Si tienes curiosidad por esta investigación, puedes leer más información aquí o en el blog de Google.

Más información | Google Research