Image: Algoritmos, ¿más allá del bien y del mal?

Algoritmos, ¿más allá del bien y del mal?

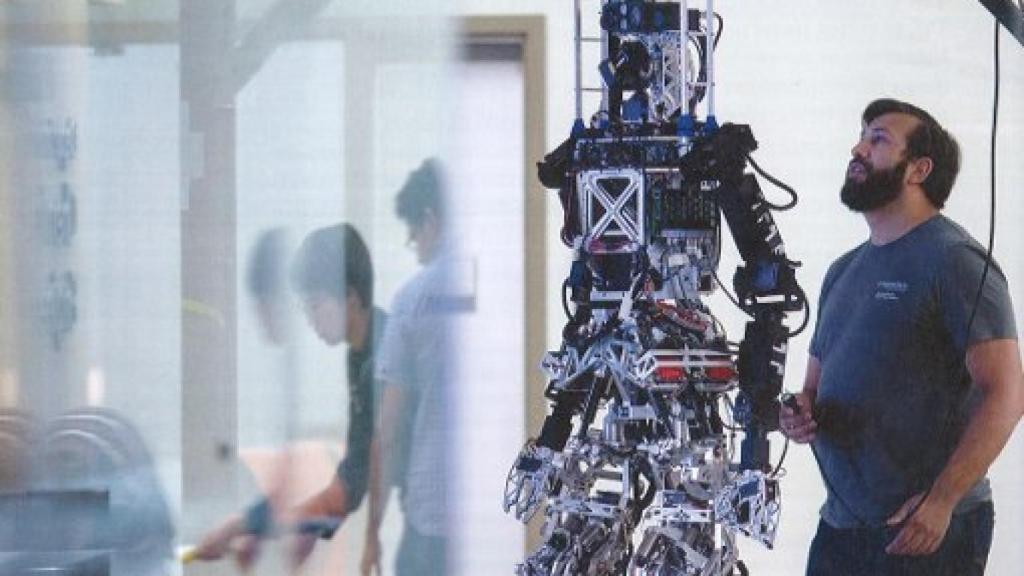

Robot Thor de El próximo paso. La vida exponencial (BBVA/Open Mind)

Del ajedrez a los móviles, de los robots domésticos al transporte, de la medicina al Big Data, de la poesía al arte pasando por la música, el cine y la investigación... La Inteligencia Artificial lo filtra todo. El desarrollo tecnológico y sus algoritmos nos sitúan en el futuro preconizado por Asimov o Philip K. Dick. José Manuel Sánchez Ron, Pedro Meseguer, Carme Torras y Lorena Jaume-Palasí reflexionan sobre su presente y su futuro, sobre el aprendizaje profundo de los robots, sobre su relación con el ser humano y sobre la encrucijada ética de su implantación.

El grado de precisión con el que dicha tecnología puede desempeñar tareas concretas sobrepasa la capacidad humana. Y la semántica de uso humanizante que la acompaña -Inteligencia Artificial, redes neuronales artificiales, aprendizaje de máquinas- está generando miedo, incertidumbre y duda. ¿Son los robots y los productos que estamos programando con algoritmos más inteligentes que el ser humano? ¿Acabarán sustituyendo a millones de trabajadores en el mercado? ¿Van a alzarse contra el hombre e intentar dominarlo? ¿Qué beneficios puede aportar esta tecnología a nuestra sociedad? ¿Dónde se debería aplicar?

La Inteligencia Artificial no es inteligente. La IA es un proceso de automatización que se genera programando algoritmos y alimentándolos con grandes bases de datos -datos muy heterogéneos y no estructurados, denominados Big Data-. Los algoritmos se podrían comparar en cierto grado con una receta de cocina y el Big Data con los ingredientes. El algoritmo, al igual que la receta, depende de sus ingredientes para hacer un buen pastel. Y como toda receta, cada algoritmo tiene su toque personal. Y ahí yace uno de los riesgos más sutiles: la tecnología creada ni es buena ni es mala, pero tampoco es neutral. Los algoritmos son construidos por personas y son un lenguaje con el que se formalizan cadenas de órdenes y comandos. Como todo lenguaje, es extremadamente subjetivo y contiene prejuicios de los que tal vez el equipo de programación no es consciente. Con todo ello puede ocurrir que el proceso algorítmico programado para reclutar personal en una compañía discrimine a mujeres o a minorías. Si para determinar si alguien tiene capacidad de liderazgo sólo se consideran candidatos con experiencia en cargos de dirección -en vez de considerar otras características adicionales como por ejemplo cualidades de pensamiento analítico y estratégico- se discriminará indirectamente a mujeres, ya que éstas siguen teniendo menor experiencia como líderes.

Los proyectos de ciudad inteligente organizan la infraestructura de una ciudad, sea el transporte público o la distribución de electricidad. Si dichos procesos se organizan únicamente con el mero criterio de la eficiencia y no se consideran otros aspectos como la equidad, las zonas con habitantes menos pudientes acabarán siendo discriminadas. Ello se debe a que los barrios más ricos suelen estar más digitalizados y la base de datos con la que operan dichos programas es mayor que la de zonas menos acaudaladas. Al poseer más información los programas pueden calcular con más rigor las necesidades de los habitantes de ese barrio.

Con procesos algorítmicos se pueden encasillar a personas en perfiles de los que les puede resultar difícil salir, puesto que no son conscientes de estar siendo manipulados en una determinada dirección. Citando al economista Paul Krugman: compra online y encontrarás todo lo que necesitas. Ve a una librería y encontrarás lo que no estás buscando. Pese a la previa alegoría culinaria, el fin del proceso algorítmico no es un pastel, sino ver con qué probabilidad determinados patrones de comportamiento o acción se repiten y están interrelacionados. Es la idea de que el futuro es una repetición de lo que hemos hecho en el pasado. Pero el futuro no es siempre igual que el pasado. Los procesos algorítmicos son incapaces de recontextualizar patrones de comportamiento pasado ante nuevas circunstancias. Ello explica por qué el progreso en la programación de robots destinados a asistir a pacientes sigue siendo bastante limitado.

Por otro lado esta tecnología es consistente, a diferencia del ser humano. Según un estudio del psicólogo Daniel Kahneman publicado a fines de diciembre del 2016, las profesiones en las que se deben emitir juicios subjetivos como los ejecutivos, banqueros o jueces, se caracterizan por un alto grado de inconsistencia. Aspectos como el mal tiempo, el no haber comido o que el equipo preferido haya perdido el último partido de fútbol pueden influir en las decisiones de un juez. La Inteligencia Artificial puede detectar este tipo de comportamiento y ayudar al individuo a reconsiderar sus decisiones. El sector público puede utilizarlo para organizar la estructura del país de manera más eficiente y equitativa.

La automatización tiene un doble filo: con algoritmos podemos detectar los patrones de discriminación más sutiles y adentrarnos en los comportamientos y aspectos de la desigualdad que pasan más desarpercibidos. Asímismo, la automatización ambiciona democratizar el acceso a servicios de asistencia con el uso de sirvientes mecánicos como programas de software o robots, cada vez más asequibles para un mayor número de personas. Ello puede librar al ser humano de tareas repetitivas, proporcionándole libertad para dedicar atención a actividades más complejas. Por otro lado, el delegar tareas a una software o robot implica obligatoriamente la pérdida de espontaneidad y autonomía en esas tareas, el encasillamento voluntario en perfiles basados en comportamientos.

La Inteligencia Artificial esconde un gran potencial para el ser humano y la sociedad en general pero también grandes riesgos. Sólo podremos disfrutar sus beneficios si nos aseguramos un control constante y democrático.

Lorena Jaume-Palasí es directora de AlgorithmWatch y profesora de la Universidad de Múnich.