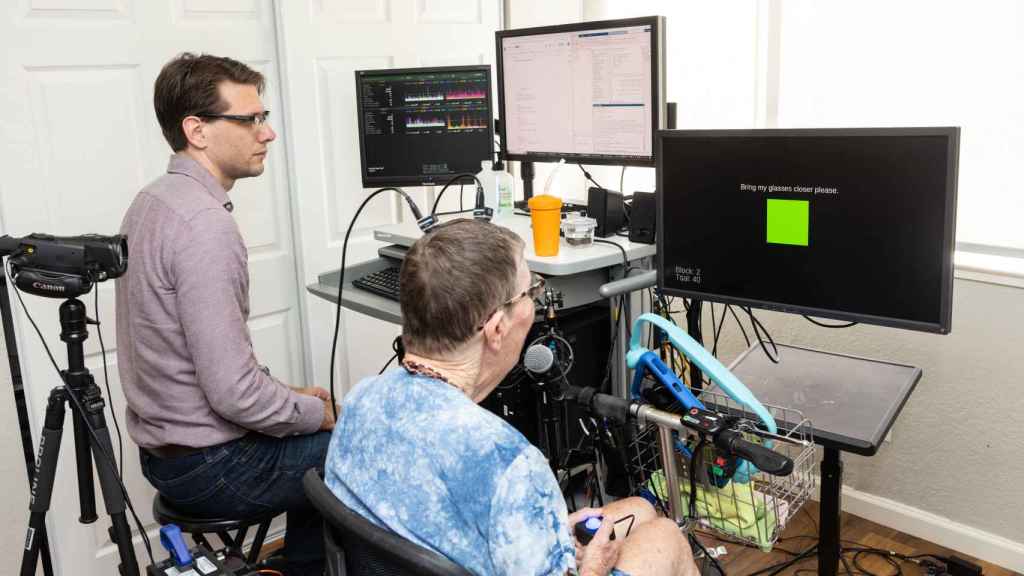

La paciente durante una de las sesiones para traducir su pensamiento en texto

Diseñan unos implantes cerebrales que 'devuelven el habla' a pacientes con parálisis y ELA

Dos nuevos interfaces máquina-cerebro consiguen batir récords de velocidad en la conversión de pensamiento en texto en pacientes con parálisis grave.

Una de las consecuencias más graves de una enfermedad como la esclerosis lateral amiotrófica, conocida como ELA, es la pérdida del habla. Desde hace años, existen tecnologías que buscan ofrecer a esos pacientes y a las personas que sufren algún tipo de parálisis grave nuevas maneras de comunicarse, pero hasta la fecha no han conseguido una velocidad ni una precisión comparables a las de una conversación normal.

Sin embargo, los avances en las interfaces cerebro-ordenador (BCI) están revolucionando este panorama, como desvela un artículo publicado hoy mismo en la revista Nature. Los equipos detrás de estas investigaciones han sido capaces de presentar resultados que demuestran que sus sistemas pueden descodificar la actividad cerebral en habla con mayor rapidez, precisión y vocabulario que todos los métodos aplicados con anterioridad.

Ambos interfaces, desarrollados por investigadores de las universidades de Stanford, San Francisco y Berkeley, representan un gran avance para la neurociencia y la neuroingeniería. Sus avances plantean un nuevo paradigma para evitar que quienes sufren lesiones y enfermedades neurológicas paralizantes pierdan la habilidad de comunicarse con otras personas.

Distintos métodos

En marzo de 2022, el neurocirujano Jaimie Henderson, de la Universidad de Stanford, colocó dos diminutos sensores con finos electrodos en dos regiones distintas del cerebro de Pat Bennet, una mujer de 67 años con ELA en fase avanzada. Combinados con un software de descodificación de última generación, esos pequeños dispositivos se encargaron de traducir la actividad cerebral relacionada con el habla en texto escrito en una pantalla.

Apenas un mes después de la operación, el resto del equipo de científicos de Stanford implicados en la investigación, liderado por Francis Willett, empezó a realizar dos sesiones por semana con Bennett para entrenar la red neuronal artificial que interpretaba su habla. Sólo 4 meses después, los pensamientos de la paciente se convertían en palabras en una pantalla de ordenador, a una velocidad de 62 palabras por minuto, 3,4 veces más rápido que el récord anterior de comunicación asistida por BCI.

El implante que ha devuelto el habla a una paciente de esclerosis lateral amiotrófica

Bennett consiguió decir incluso frases que no estaban incluidas en los conjuntos de datos del entrenamiento, usando una biblioteca de 50 palabras. Lo siguiente era conseguir los datos recogidos de estas sesiones y correlacionarlos con las señales y las palabras. Así, los investigadores consiguieron desarrollar e implementar en su BCI un sistema de predicción de palabras, para aumentar la precisión de la interfaz: si la paciente intentaba escoger una palabra entre varias, el software elegiría la más probable.

[Este diminuto dispositivo es un ingenioso implante capaz de luchar contra el cáncer más agresivo]

El BCI todavía está lejos de la velocidad de una conversación natural, que se produce a unas 160 palabras por minuto, pero su mejora con respecto a los métodos existentes hasta la fecha es muy notable. Y es que no sólo importa la velocidad, también la precisión: su tasa de error se redujo al 9,1% con un vocabulario de 50 palabras, 2,7 veces menos que el anterior BCI, presentado en 2021. Cuando el vocabulario se amplió a 125.000 palabras, la tasa de error ascendió al 23,8%.

El avatar que habla

El otro BCI, desarrollado por investigadores de la Universidad de San Francisco y la Universidad de Berkeley (California) y liderado por el neurocientífico Edward Chang, recurrió a un método distinto. Chang y su equipo utilizaron un rectángulo fino como el papel con 253 electrodos, colocado en la superficie del cerebro de una mujer con parálisis tras un derrame cerebral, para detectar la actividad de muchas células a la vez en distintos puntos de todo el córtex del habla.

La paciente con parálisis grave pudo comunicarse a través de un avatar Omicrono

Gracias a esta novedosa aproximación, los investigadores consiguieron generar tres salidas simultáneas: texto, habla audible y un avatar virtual capaz de hablar. Para conseguir sus resultados, diseñaron un modelo de aprendizaje profundo para descifrar los datos neuronales generados por la paciente mientras intentaba pronunciar frases completas en completo silencio.

Esta BCI superó los resultados de la de Stanford, logrando una tasa media de 78 palabras por minuto, es decir, 4,3 veces más rápida que la cifra del récord anterior. Su tasa de error también es inferior, con sólo un 4,9% de fallos al descodificar frases de un conjunto de 50 palabras. O lo que es lo mismo, 5 veces menos errores que el anterior BCI de voz de última generación.

El avatar refleja las expresiones faciales de la paciente con parálisis

Al aumentar el vocabulario, como es lógico, también aumentó el porcentaje de error: con más de 1.000 palabras alcanzó un 25% de fallos, mientras simulaciones offline detectaron una tasa del 28% cuando el vocabulario ascendía a 39.000 palabras.

Pero lo realmente novedoso del método de Chang es su multimodalidad. Los electrodos y el software se encargaron de traducir directamente en una voz sintetizada un conjunto de 529 frases, con un margen de error del 28%. Además, la BCI se encargó de descodificar la actividad neuronal en movimientos faciales de un avatar a través de una pantalla, que también reflejó las expresiones no verbales de la paciente.

Tras varios meses de pruebas, los investigadores demostraron que su método era estable y ofrecía un alto rendimiento, además de permitir una comunicación más natural y expresiva. Todavía es necesaria más investigación y nuevos ensayos clínicos con otros sujetos, pero los resultados son muy prometedores.

También te puede interesar:

- Elon Musk probará su chip cerebral en humanos: "Podemos devolver la vista a los ciegos"

- Un grupo de neuronas aprenden a jugar al Pong para estudiar el impacto de las drogas en el cerebro

- La prótesis del habla: el 'chip' que traduce señales del cerebro en palabras

- El mapa del cerebro más detallado hecho nunca es de Google